Entfesseln Sie das Potenzial Ihrer NLP-Projekte mit dem richtigen Talent. Veröffentlichen Sie Ihre Stelle bei uns und ziehen Sie Kandidaten an, die genauso leidenschaftlich über natürliche Sprachverarbeitung sind.

NLP-Experten einstellenIch habe eine kurze Auswahl einiger datenwissenschaftlicher Konzepte für Fortgeschrittene zusammengestellt, die Ihnen eine gute Grundlage in diesem Bereich vermitteln. Viele davon basieren auf einer Reihe von Artikeln, die ich für die hervorragende Datenwissenschaftsressource deepai.org geschrieben habe. Ich habe die Liste der datenwissenschaftlichen Konzepte ein wenig auf die Verarbeitung natürlicher Sprache ausgerichtet, da dies der Bereich ist, in dem ich hauptsächlich arbeite.

Eine Aktivierungsfunktion wird in neuronalen Netzen verwendet und fungiert als „Gatekeeper“. Es lässt große Signale durch, blockiert aber kleine Signale.

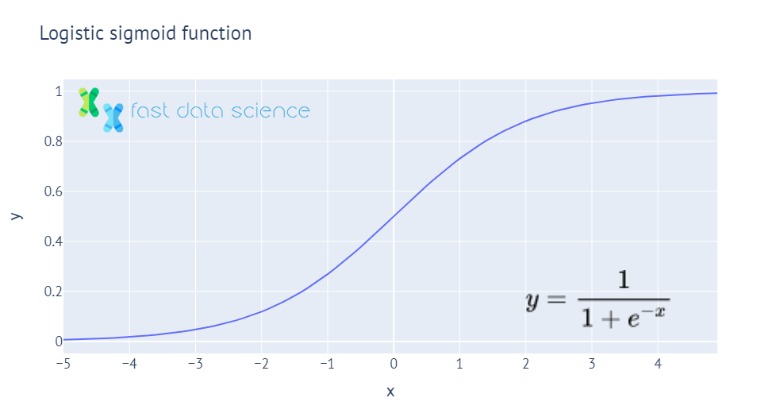

Zwei der häufigsten Aktivierungsfunktionen, die logistische Sigmoidfunktion und die ReLU-Funktion. Alle Aktivierungsfunktionen geben einen kleinen Wert für kleines x und einen großen Wert für großes x aus und sind nichtlinear.

Aktivierungsfunktionen wurden vom Aktionspotential inspiriert, das eine Blockierfunktion in biologischen neuronalen Netzwerken darstellt.

Zwei britische Wissenschaftler, Hodgkin und Huxley, entdeckten Aktionspotenziale in Lebewesen, indem sie die Nerven eines Tintenfischs sezierten. Dies diente später als Inspiration für die in neuronalen Netzen verwendeten Aktivierungspotentiale.

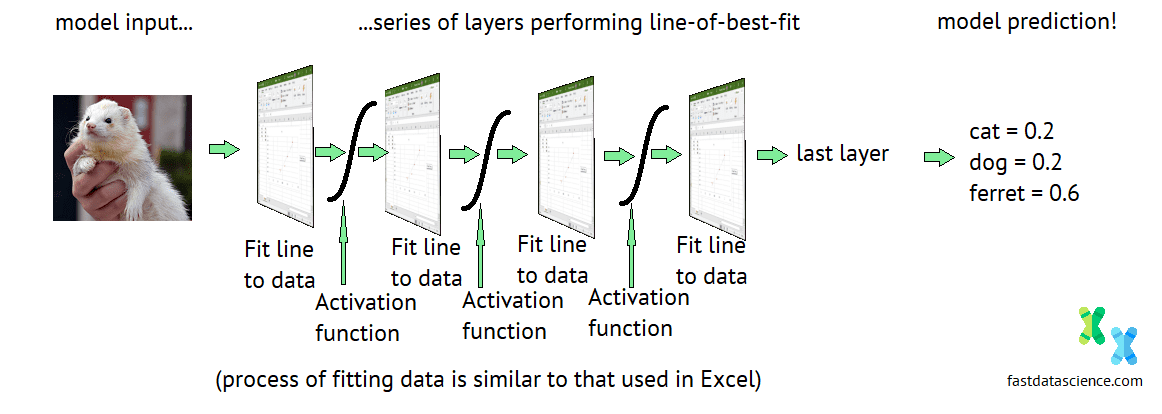

Ohne Aktivierungsfunktionen wären neuronale Netze nicht in der Lage, Objekte und Gesichter zu erkennen. Tatsächlich wären sie nicht besser als ein einfaches Regressionsmodell wie die Best-Fit-Linie in Excel.

Eine häufig gewählte Aktivierungsfunktion ist die Sigmoidfunktion .

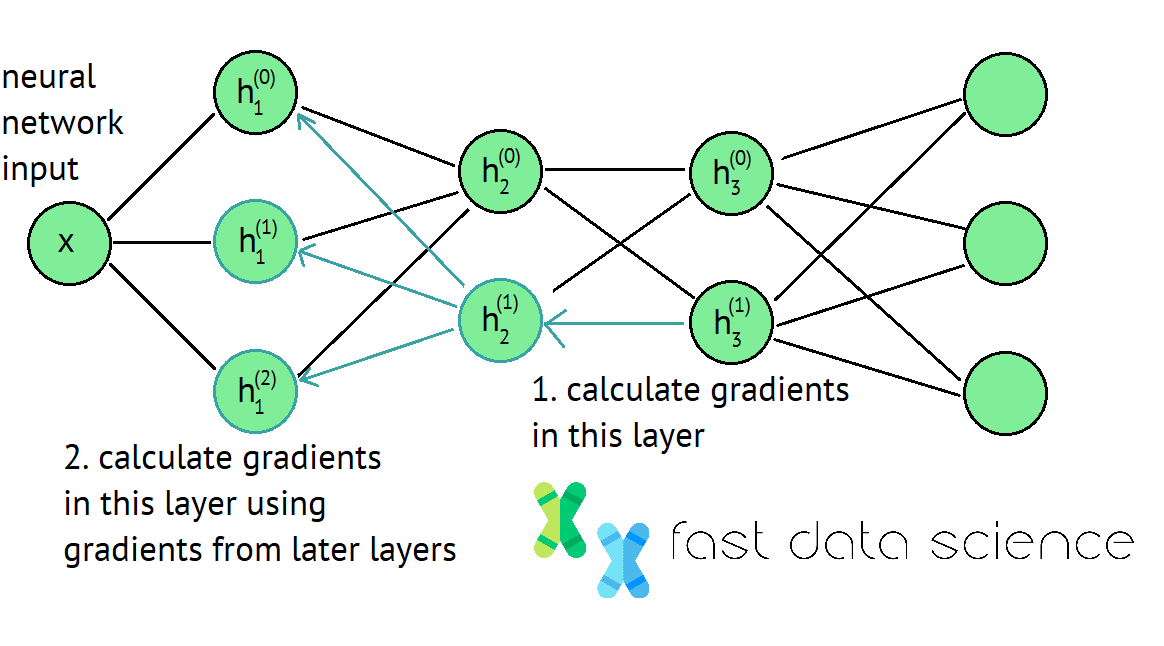

Backpropagation ist eine Technik zur effizienten Berechnung von Gewichten innerhalb tiefer neuronaler Netze. Dabei wird die Verlustfunktion am Ende des Netzwerks berechnet, dann zum Anfang des Netzwerks zurückgegangen und die Netzwerkgewichte aktualisiert.

Der Backpropagation-Algorithmus ist der Schlüssel zum Deep Learning und zur Datenwissenschaft. Dabei arbeiten Sie sich rückwärts durch ein neuronales Netzwerk vom Ende bis zum Anfang und berechnen an jedem Punkt, wie Sie die Gewichte aktualisieren müssen. Lesen Sie hier mehr Details.

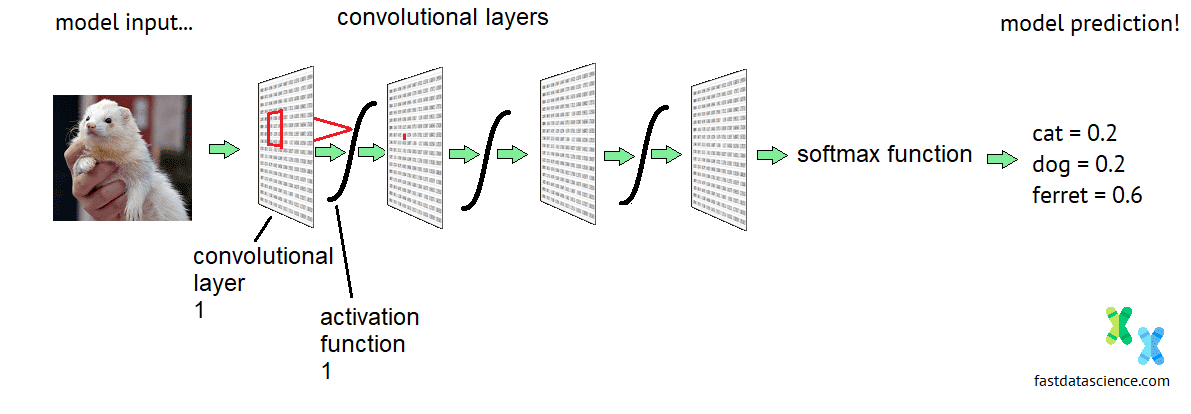

Convolutional Neural Networks sind eine spezielle Art tiefer neuronaler Netzwerke, die hauptsächlich zur Erkennung von Bildern verwendet werden. Sie verfügen über eine starre Struktur, die es ihnen ermöglicht, Muster innerhalb eines Bildes sowie Kombinationen von Mustern zu erkennen.

Schematische Darstellung der Architektur eines Faltungs-Neuronalen Netzwerks. Normalerweise verfügen Netzwerke, die Fotos oder Gesichter verarbeiten, über mindestens 20 Ebenen.

Interessanterweise sind Faltungs-Neuronale Netze nicht nur für Bilder nützlich. Sie können für Tonsignale umfunktioniert werden (Sie können jede beliebige Tonaufnahme in ein Spektrogramm umwandeln, das sich dann wie ein Bild verhält). Sie können auch ein Dokument in Englisch oder einer anderen Sprache nehmen und es in eine bildähnliche Form umwandeln, indem Sie jedes Wort durch eine Wortvektoreinbettung ersetzen.

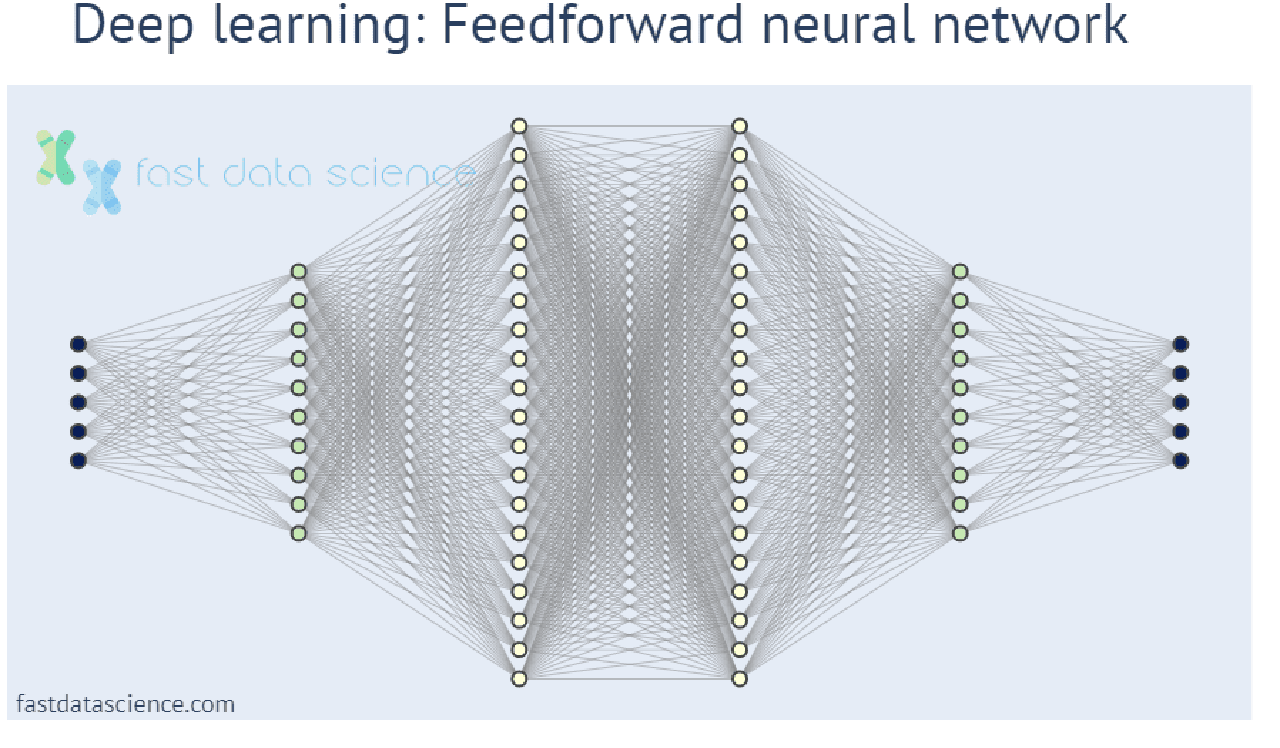

Deep Learning ist eine Art Technik des maschinellen Lernens, bei der viele einfachere Modelle des maschinellen Lernens übereinander geschichtet und mit einer Aktivierungsfunktion zusammengefügt werden. Der Aufstieg des Deep Learning hat einen Großteil der fortschrittlichen KI ermöglicht, die wir heute sehen, von maschineller Übersetzung bis hin zu Snapchat-Filtern.

Faltungs-Neuronale Netze sind, wie oben beschrieben, eine Art Deep-Learning-Modell.

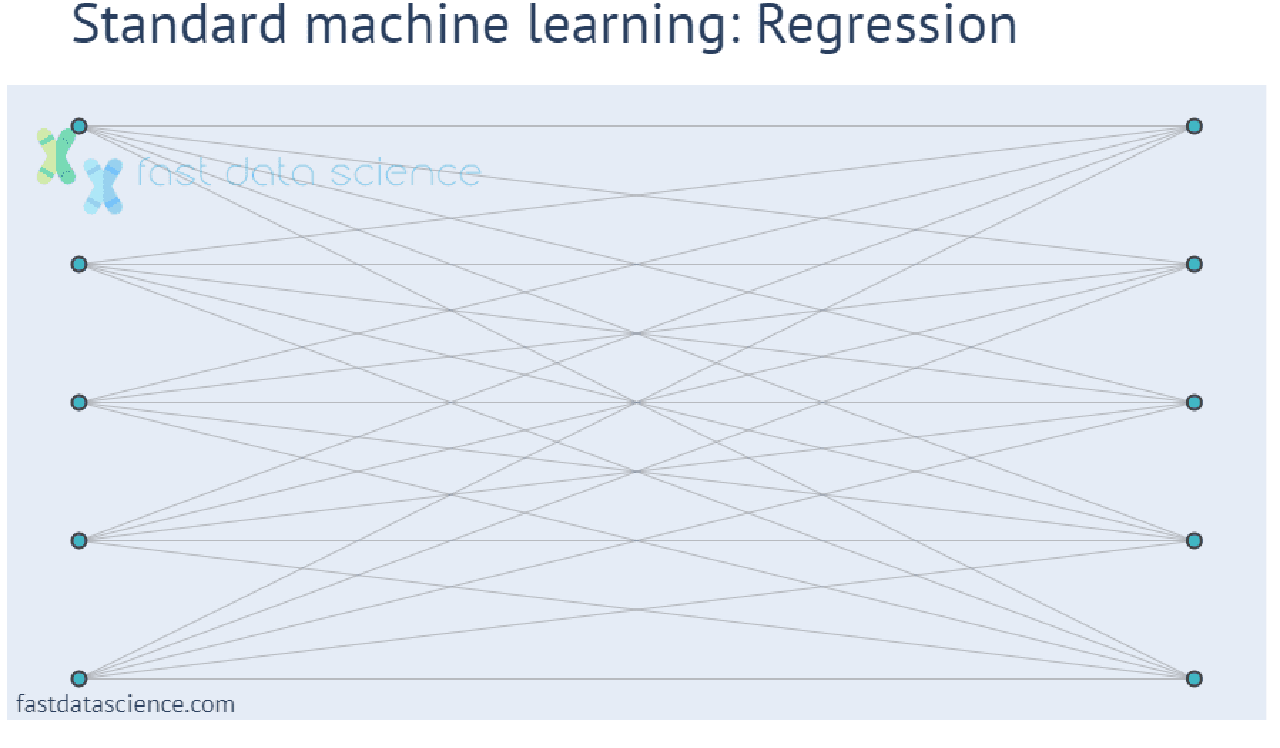

Herkömmliche Modelle für maschinelles Lernen umfassen eine viel geringere Anzahl von Parametern und führen am Ende oft nur ein paar einfache Operationen für einige eingehende Zahlen durch. Im Gegensatz dazu wird beim Deep Learning eine Zahl eingegeben (z. B. ein Pixel oder ein Fragment eines Audiosignals) und diese durchläuft viele Schichten mathematischer Operationen, bevor das Modell seine Ausgabe erzeugt:

Leider werden Deep-Learning-Modelle immer komplexer und für den Menschen schwerer zu verstehen, sodass ein Bedarf an erklärbaren KI- und erklärbaren Modellen für maschinelles Lernen entsteht.

Ein evolutionärer Algorithmus ist eine Möglichkeit, eine KI mithilfe von Methoden zu verbessern, die von der biologischen Evolution inspiriert sind, insbesondere zufällige Mutationen und natürliche Selektion.

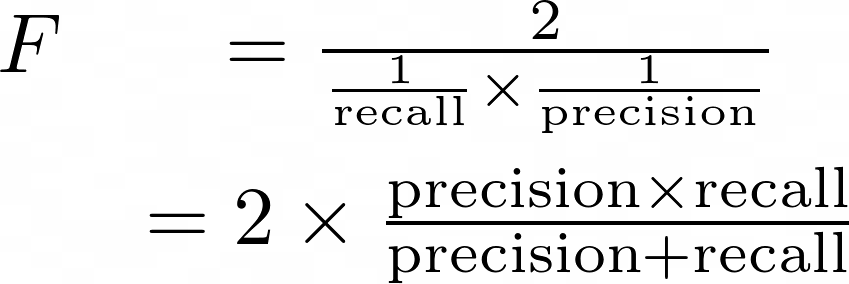

Wenn Sie ein Modell für maschinelles Lernen trainieren, kann es verlockend sein, seine Leistung anhand der Genauigkeit zu messen. Wenn beispielsweise ein Modell zur Identifizierung des Vorhandenseins/Fehlens von Tumoren eine Genauigkeit von 90 % erreicht, ist das doch gut, oder? Was aber, wenn 90 % Ihrer Patienten keinen Tumor haben und das Modell für 100 % Ihrer Patienten „kein Tumor“ vorhersagt? Das Modell ist völlig nutzlos, würde aber trotzdem 90 % erreichen! Aus diesem Grund verwenden wir den F-Score , ein robusteres Maß und wichtiges datenwissenschaftliches Konzept, das mit unausgeglichenen Klassen umgehen kann.

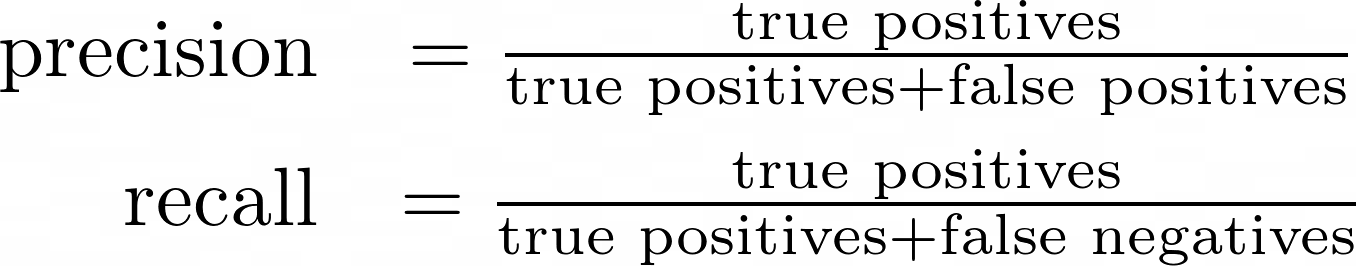

Definition des F-Scores im Hinblick auf Präzision und Erinnerung

Definition von Präzision und Rückruf in Bezug auf wahr-positive Ergebnisse (tp), falsch-positive Ergebnisse (fp) und falsch-negative Ergebnisse (fn)

Tatsächlich sollten Sie ziemlich misstrauisch sein, wenn jemand versucht, Sie dazu zu bewegen, in ein Data-Science-Modell zu investieren, und Ihnen nur eine Zahl wie „90 % Genauigkeit“ nennt! Es könnte sich durchaus um ein Problem der Datenunausgewogenheit handeln, bei dem eine Genauigkeit von 90 % sehr einfach zu erreichen ist. Der F-Score ist gegenüber dieser Art von Effekt robuster.

Ein synthetisches Gesicht, das von einem generativen gegnerischen Netzwerk generiert wird

Generative Adversarial Networks sind ein cleveres neuronales Netzwerkdesign, bei dem wir zwei neuronale Netzwerke zusammenfügen und gegeneinander ausspielen (daher das „adversarial“ im Namen). Ein Netzwerk erhält die Aufgabe, Dinge zu generieren (z. B. Gesichtsbilder), und die Aufgabe des anderen Netzwerks besteht darin, das Erzeugte von der Realität zu unterscheiden (es muss also lernen, gefälschte Gesichter von echten Gesichtern zu unterscheiden). Mit der Zeit erhalten wir durch diese kontroverse Konfiguration einen sehr ausgefeilten Generator, der lebensechte Gesichtsbilder, Musik, Kunstwerke, Videos und sogar Text erstellen kann.

Bei der Hyperparameteroptimierung handelt es sich um den Prozess der Auswahl der besten Hyperparameter oder Lernparameter für einen Algorithmus für maschinelles Lernen. Wenn Sie beispielsweise eine Gesichtserkennung mit einem neuronalen Netzwerk erstellen, möchten Sie möglicherweise mit unterschiedlichen Lernraten, Ebenenanzahlen, Lernalgorithmen, Bildabmessungen usw. experimentieren. Da jedes Mal, wenn Sie ein Modell trainieren, Monate dauern kann, ist es nicht praktikabel, mit jeder möglichen Kombination von Hyperparametern zu experimentieren, und daher ist es üblich, clevere Algorithmen zu verwenden, die schnell zu den besten Werten konvergieren.

Wenn wir einen Entscheidungsbaum trainieren, ist der Informationsgewinn die Verringerung der Entropie oder Überraschung, die wir durch die Aufteilung unseres Datensatzes auf einen bestimmten Wert einer Variablen erhalten.

Wenn wir beispielsweise entscheiden möchten, ob ein Zweig zu einem Entscheidungsbaum mit einem Schwellenwertalter > 50 hinzugefügt werden soll, würden wir ermitteln, ob dieser Cutoff zu zwei Datensätzen führt, die jeweils homogener sind als der ursprüngliche Datensatz. Die Entropieänderung entspricht dem Informationsgewinn.

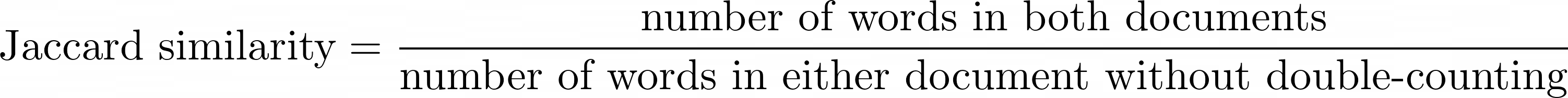

Der Jaccard-Ähnlichkeitsindex ist eine Zahl, die uns sagt, wie ähnlich zwei Dokumente einander sind. Es kann ein Prozentsatz oder eine Zahl zwischen 0 und 1 sein.

Stellen Sie sich vor, Sie möchten messen, wie ähnlich diese beiden Sätze sind:

Dokument A: „Data Science zu lernen ist einfach “

Dokument B: „Es ist einfach , Datenwissenschaftler zu werden“

Ich habe die Wörter, die in beiden Sätzen vorkommen, fett markiert.

Unabhängig davon, ob wir den Aussagen zustimmen, können wir mithilfe der Jaccard-Ähnlichkeitsindex-Formel berechnen, wie ähnlich Dokument A Dokument B ist:

Mathematische Definition des Jaccard-Ähnlichkeitsindex

Für unsere beiden Sätze gibt es also zwei gemeinsame Wörter und insgesamt zehn Wörter. Wir können die Berechnung in einem Venn-Diagramm visualisieren:

Venn-Diagramm zur Berechnung des Jaccard-Ähnlichkeitsindex für zwei Sätze. Die Sätze bestehen ohne Doppelzählung aus insgesamt 10 Wörtern, und in beiden Dokumenten kommen zwei Wörter vor, was einen Jaccard-Ähnlichkeitsindex von 20 % ergibt.

Aus dem Venn-Diagramm lässt sich leicht erkennen, dass die beiden Dokumente eine Jaccard-Ähnlichkeit von 20 % aufweisen, also einander zu 20 % ähnlich sind. Wenn zwischen den Dokumenten keine gemeinsamen Wörter vorhanden wären, würde die Ähnlichkeit 0 betragen.

Da es fraglich ist, ob „Wissenschaft“ und „Wissenschaftler“ etwas ähnlich sind, können wir manchmal den Jaccard-Index auf Unterwortebene verwenden. Zum Beispiel könnten wir Sequenzen aus drei Buchstaben nehmen, die Trigramme genannt werden: „sci“, „cie“, „ien“, „ent“, „nti“, „tis“, „ist“ – mit diesem Maß „science“ und „ „Wissenschaftler“ haben eine Ähnlichkeit von 33 %.

Es gibt eine Reihe von Alternativen zum Jaccard-Index, beispielsweise den Kosinus-Ähnlichkeitsindex .

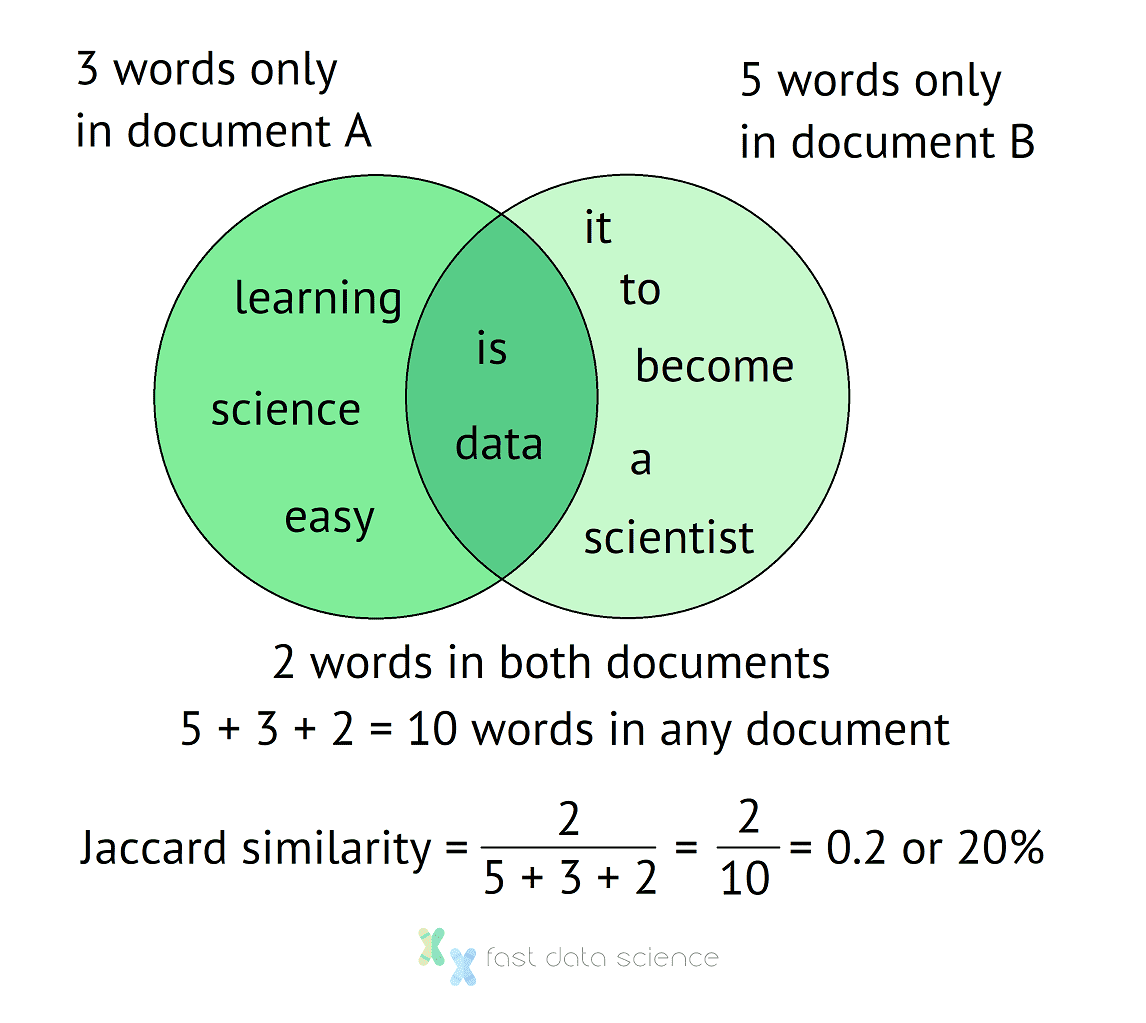

K-Means-Clustering ist ein äußerst einfacher Algorithmus zum Clustering oder zum Erkennen von Gruppen und Themen in einem Datensatz. Stellen Sie sich zum Beispiel vor, Sie haben 100 Nachrichtenartikel zu verschiedenen Themen. Sie können den K-Means-Clustering-Algorithmus verwenden, um herauszufinden, dass der Datensatz fünf Themen enthält: Sport, Politik, Technologie, Welt und Wirtschaft. K-means funktioniert für alle Arten von Daten, nicht nur für Text. Beispielsweise können Unternehmen ihre Kunden anhand von Präferenzen und Ausgabemustern in Schichten einteilen.

Fast Data Science - London

Animation, die zeigt, wie der K-Means-Algorithmus funktioniert. Zunächst werden die Clusterzentren zufällig ausgewählt. Dann wechseln wir zwischen der Zuweisung jedes Datenpunkts zu seinem nächstgelegenen Cluster und der Neuberechnung des Mittelpunkts jedes Clusters anhand aller seiner Datenpunkte, bis sich die Clusterzuweisungen nicht mehr ändern.

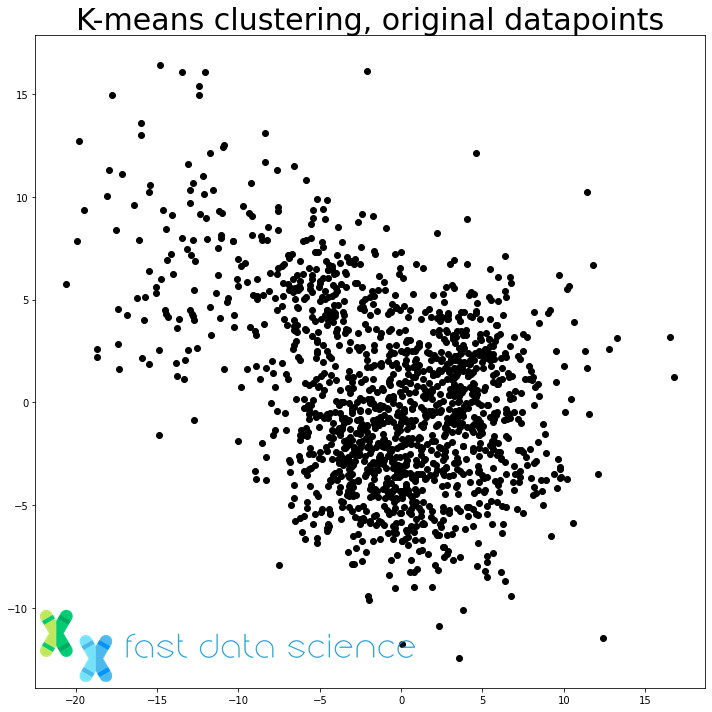

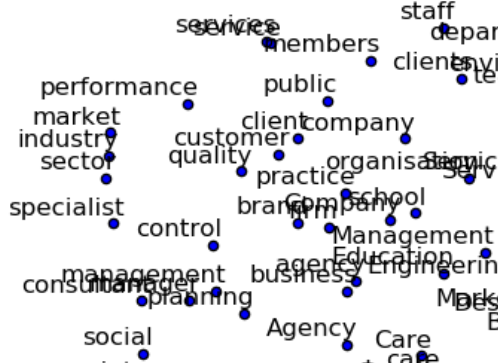

Latent Dirichlet Allocation (LDA) ist ein Algorithmus, der in der Verarbeitung natürlicher Sprache zum Clustern von Textdokumenten verwendet wird. LDA ist ausgefeilter als K-Means und kann Dokumente mit jeweils einer Wahrscheinlichkeit mehreren Kategorien zuordnen.

Visualisierung von Clustern, die durch die Latent-Dirichlet-Analyse zugewiesen wurden, unter Verwendung von Text aus dem British National Corpus (BNC). Der Clustering-Algorithmus gibt auch Gewichtungen für Wörter im Korpus aus, sodass wir jedes neu eingehende Dokument problemlos einem Cluster zuordnen können.

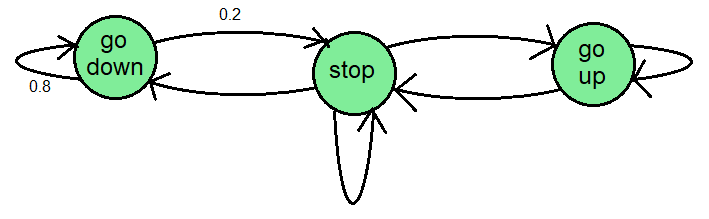

Eine Markov-Kette ist ein einfaches Modell, mit dem der Zustand eines Systems als Knoten in einem Diagramm definiert wird. Ein Aufzug hat beispielsweise drei Zustände: angehalten, hochfahrend und runterfahrend. Eine Markov-Kette könnte entworfen werden, um diese drei Zustände als Knoten in einem Diagramm darzustellen, wobei Übergangswahrscheinlichkeiten angeben, wie wahrscheinlich es ist, dass das System von einem Zustand in einen anderen wechselt.

Ein Schema, wie eine Markov-Kette für einen Aufzug aussehen könnte. Es gibt drei Zustände und Zahlen auf den Übergängen geben die Wahrscheinlichkeiten an.

Viele Modelle des maschinellen Lernens, insbesondere Modelle zur Sprach- und Handschrifterkennung, basieren auf Hidden-Markov-Modellen , die dem Konzept der Markov-Kette ähneln, mit der Ausnahme, dass der Zustand des Modells nicht sichtbar ist (z. B. das in a ausgesprochene Wort). Sprachaufzeichnung) und wir können nur die von jedem Zustand ausgegebenen Werte beobachten (die die in der Aufzeichnung aufgezeichneten Daten darstellen).

Schließlich sind Markov Chain Monte Carlo (MCMC)-Modelle sehr leistungsstarke Werkzeuge für maschinelles Lernen (obwohl sie sehr langsam und schwer zu berechnen sind). Sie ermöglichen es uns, Stichproben aus einer beliebigen Wahrscheinlichkeitsverteilung zu generieren. Dadurch können wir Wahrscheinlichkeitsverteilungen auf clevere Weise manipulieren. Sie können beispielsweise eine Regressionslinie für einen Datensatz berechnen und dabei eine starke vorherige Annahme einbeziehen, dass der Achsenabschnitt 0 ist. Dies bedeutet, dass Sie Modelle erstellen können, die Informationen aus Trainingsdaten und Informationen aus früheren Überzeugungen kombinieren.

Die einfachste Art von Textklassifizierer, die Sie erstellen können, ist ein Naive-Bayes-Klassifikator. Dies ist ein grundlegendes NLP- und Data-Science-Konzept. Wenn Sie beispielsweise einen Spamfilter erstellen möchten, der E-Mails als Spam oder Ham (unerwünschte oder angeforderte E-Mails) kategorisiert, ist der Naive Bayes Classifier das einfachste Tool für diese Aufgabe. Es wird „naiv“ genannt, weil es davon ausgeht, dass der Text aus einer Gruppe zufällig vorkommender Wörter besteht, die voneinander unabhängig sind. Auch wenn dies nicht stimmt, funktionieren naive Bayes-Klassifikatoren überraschend gut und es ist ganz einfach, einen eigenen funktionierenden Textklassifikator zu erstellen.

Mathematische Optimierung ist eine ergänzende Technik zum maschinellen Lernen und überschneidet sich manchmal mit maschinellem Lernen. Optimierung wird oft ausgedrückt als: Auswahl der besten Option aus einer Reihe von Optionen, wodurch die Kosten minimiert werden.

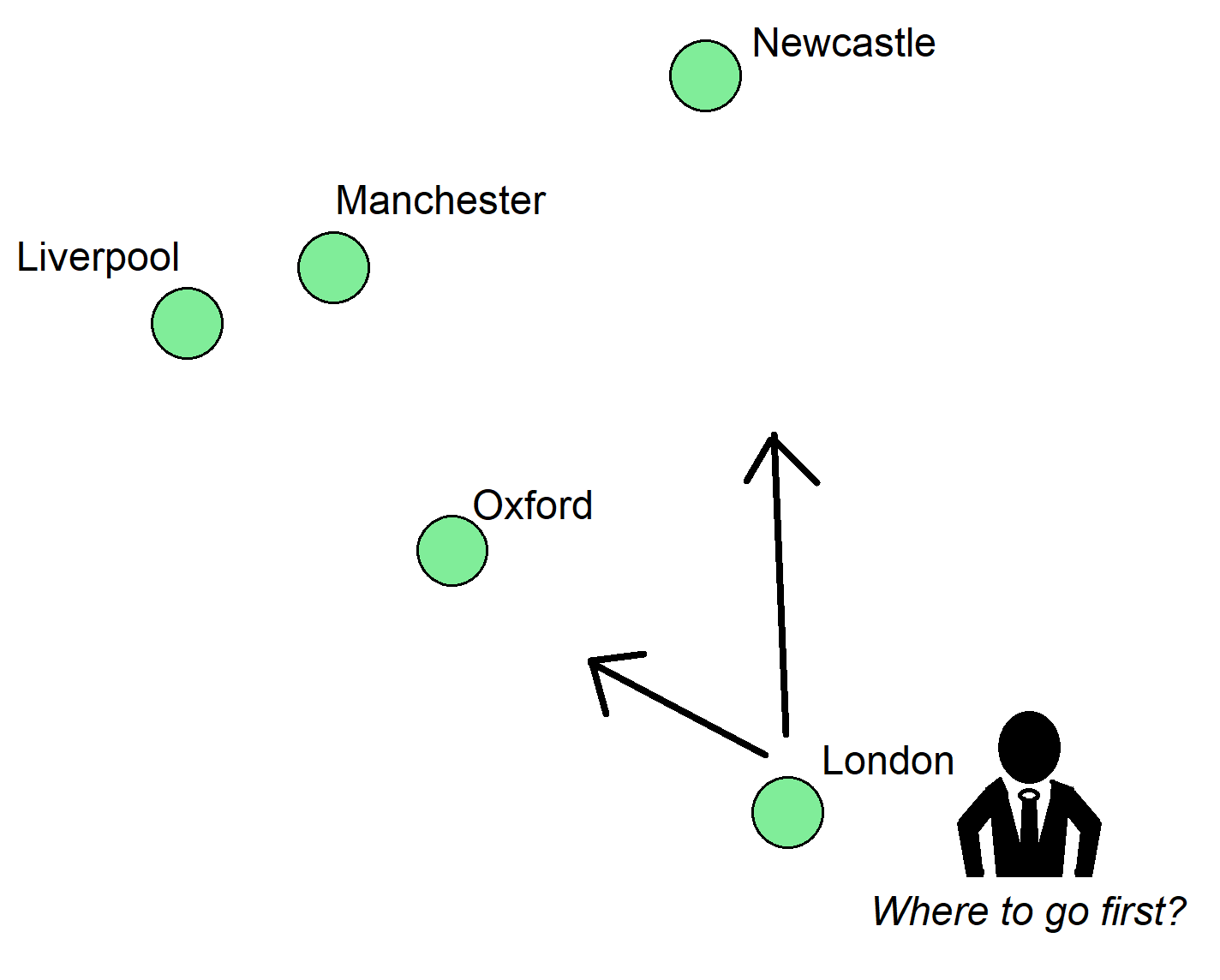

Beispiele für klassische Optimierungsprobleme sind das Travelling-Salesman-Problem (bei dem ein Verkäufer den kürzesten Weg durch alle Städte auf seiner Reiseroute finden muss) und das Bin-Packing-Problem. Dabei müssen Gegenstände unterschiedlicher Größe effizient in eine begrenzte Anzahl von Behältern verpackt werden.

Das Problem des Handlungsreisenden ist ein klassisches Optimierungsproblem. Stellen Sie sich vor, unser Verkäufer muss diese fünf Städte besuchen. Wenn er die Entfernungen zwischen ihnen kennt, was ist dann die kürzeste Route, die in jeder Stadt nur einmal und nur einmal anhält?

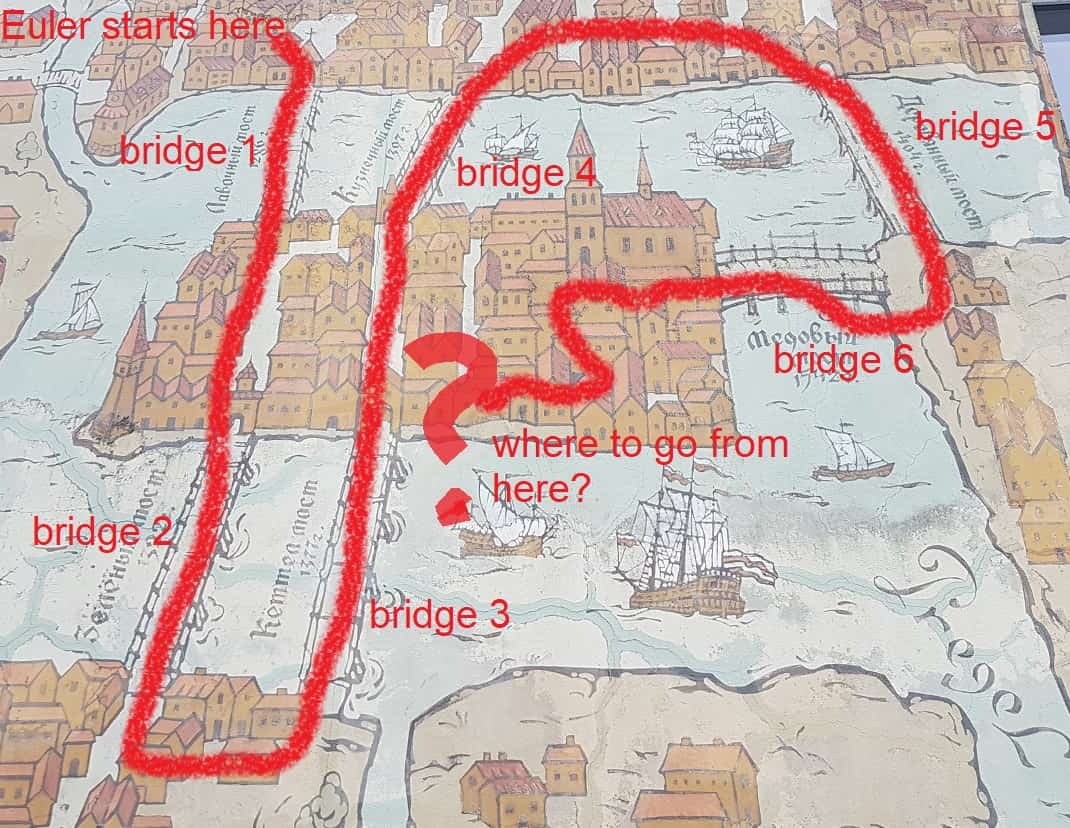

Karte des historischen Kaliningrad, Russland. Der Mathematiker Leonhard Euler stellte fest, dass es unmöglich sei, über alle Brücken der Stadt zu laufen und am Ausgangspunkt anzukommen. Dies ist eine Art Optimierungsproblem, das Routing-Problem genannt wird. Euler gründete einen neuen Zweig der Mathematik, die Graphentheorie, um seinen Sonntagsspaziergang zu verbessern. Eulers Problem ist als „Sieben Brücken von Königsberg“ bekannt.

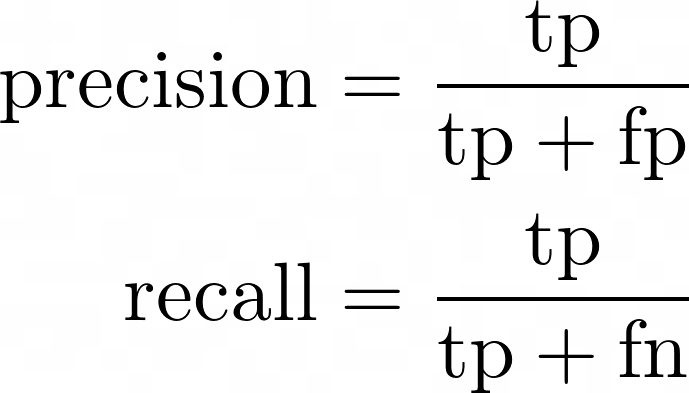

Präzision und Rückruf sind zwei Zahlen, anhand derer wir die Leistung eines Modells bewerten. Ihr bekanntester Einsatz ist die Auswertung von Suchmaschinen. Präzision stellt dar, wie relevant die Ergebnisse der Suchmaschine sind, und Erinnerung stellt deren Abdeckung dar. Es ist viel aussagekräftiger, die Leistung eines Modells in Bezug auf Präzision und Rückruf anzugeben, z. B. Präzision = 0,8, Rückruf = 0,4, als die Genauigkeit zu verwenden.

Mathematische Definitionen von Präzision und Erinnerung

Stellen wir uns vor, Sie arbeiten in einer Fabrik und verfügen über ein maschinelles Lernmodell, das Produktfehler erkennt. Sie testen das Modell an zehn Produkten und stellen fest, dass fünf Produkte korrekt als fehlerhaft identifiziert wurden ( echt positiv ), eines fälschlicherweise als fehlerhaft identifiziert wurde, aber tatsächlich in Ordnung war ( falsch positiv ), zwei korrekt als negativ identifiziert wurden ( echt negativ ) und zwei waren Eigentlich defekt, aber das Modell fing dann nicht an ( falsch negativ ). Wir können eine Verwirrungsmatrix erstellen, die darstellt, wie viele Produkte wir richtig und falsch gemacht haben und welche Arten von Fehlern wir gemacht haben:

| Really defective | Really not defective | |

| Model found defect | tp = 5 | fp = 1 |

| Model didn't find defect | fn = 2 | tn = 2 |

Verwirrungsmatrix eines maschinellen Lernmodells, das Produktfehler identifizieren soll

Wir können die Zahlen aus der Verwirrungsmatrix nehmen und sie in die Formeln für Präzision, Erinnerung und F-Score oben einfügen, um Folgendes zu erhalten:

Diese drei Zahlen sind viel aussagekräftiger als die Angabe der Genauigkeit allein.

Q-Learning ist eine Technik des verstärkenden Lernens, die es einem Roboter ermöglicht, eine Richtlinie oder allgemeine Strategie zu erlernen, die er auf zukünftige Situationen anwenden wird. Es gibt eine Belohnungsfunktion Q , die die Belohnung darstellt, die der Roboter für eine bestimmte Aktion erwartet.

Wenn zum Beispiel ein Roboter Schach spielen lernt, hat vielleicht ein Zug Q = 0,8 und der andere Zug Q = 0,2, basierend auf früheren Spielen gegen Menschen. Der Roboter würde nicht immer unbedingt das höchste Q wählen, da es manchmal notwendig ist, andere Möglichkeiten zu erkunden. Dies wird als Kompromiss zwischen Exploration und Ausbeutung bezeichnet.

Eine schachspielende KI hätte für jeden möglichen Zug, den sie ausführen kann, einen Q-Score berechnet, aber sie würde nicht unbedingt immer den Zug mit der höchsten Punktzahl ausführen, da sowohl „Erkundung“ als auch „Ausbeutung“ einen Wert haben.

Q-Learning lässt sich wie folgt zusammenfassen:

Ein Random Forest ist ein maschineller Lernalgorithmus, der für nahezu jede Aufgabe verwendet werden kann. Random Forests sind äußerst robust und gut in der Lage, inhomogene Daten wie Tabellen mit Kundeninformationen unterschiedlicher Datentypen (Alter, Geschlecht, Kreditwürdigkeit, frühere Ausgaben) anzupassen.

Aus diesem Grund werden Random Forests häufig für Geschäftsanwendungen verwendet. Eine Alternative zu Random Forests ist ein Gradient Boosted Tree.

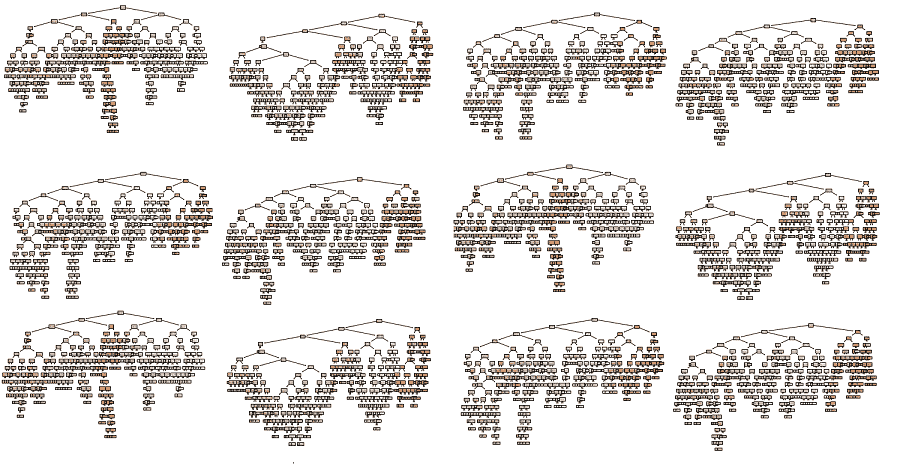

Ein einzelnes Random-Forest-Modell könnte aus Tausenden komplexer und ungenauer Entscheidungsbäume bestehen. Diese Bäume stimmen alle gemeinsam ab, um die beste Antwort zu erhalten.

Ein Random-Forest-Modell besteht aus vielen Entscheidungsbäumen, die alle anhand einer Momentaufnahme der Daten trainiert wurden. Jeder Entscheidungsbaum allein ist nicht sehr genau (sie sind „schwache Lernende“), aber die Kombination ihrer Ergebnisse kann sehr genau sein. Das ähnelt ein wenig dem klassischen Rummelplatzspiel „Errate das Gewicht des Schweins“, bei dem die durchschnittliche Schätzung aller Teilnehmer überraschend genau sein kann.

Die Sigmoidfunktion ist eine mathematische Funktion mit einer S-förmigen Kurve. Die Sigmoidfunktion wird in vielen Bereichen des maschinellen Lernens verwendet, beispielsweise in der logistischen Regression, wo sie eine Zahl in eine Wahrscheinlichkeit zwischen 0 und 1 übersetzt. Die bekannteste Sigmoidfunktion ist die logistische Sigmoidfunktion, die wie folgt aussieht:

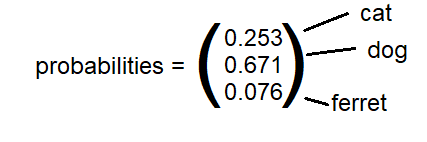

Die Softmax-Funktion ist eine Verallgemeinerung der Sigmoidfunktion auf viele Dimensionen. Wenn Sie beispielsweise ein Faltungs-Neuronales Netzwerk trainieren, um Bilder in „Katze“, „Hund“ oder „Frettchen“ zu klassifizieren, wäre die letzte Schicht eine „Softmax“-Schicht, die drei Wahrscheinlichkeiten ausgeben würde, die in der Summe eins ergeben.

Ein Transformer ist ein hochmodernes neuronales Netzwerkdesign, das für die Verarbeitung sequenzieller Daten wie Textklassifizierung, maschinelle Übersetzungen, Audioaufzeichnungen, Genomsequenzen und Musik sehr nützlich ist. Ein transformatorisches neuronales Netzwerk verfügt über eine Komponente namens Aufmerksamkeitsmechanismus, die es dem Transformator ermöglicht, bei der Verarbeitung bestimmte Wörter links und rechts von einem bestimmten Wort besonders zu beachten. Der Aufmerksamkeitsmechanismus ermöglicht es beispielsweise, das Wort „it“ in das französische oder spanische Wort des entsprechenden Geschlechts zu übersetzen, indem man auf den gesamten Satz achtet.

Das bekannteste transformatorbasierte Modell ist BERT (Bidirektionale Encoder-Repräsentationen von Transformers), das 2018 von Google als Open-Source-Lösung veröffentlicht wurde.

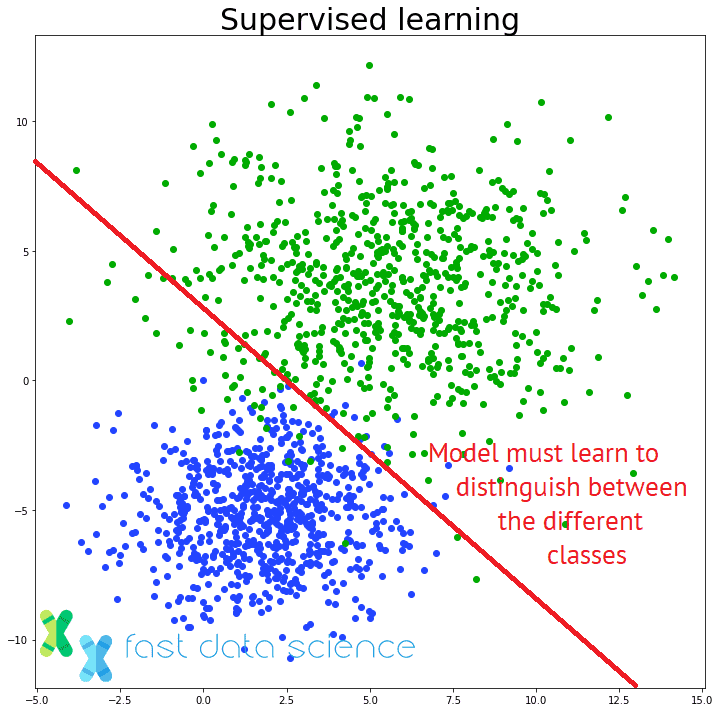

Die bekanntesten Algorithmen für maschinelles Lernen sind überwachte Lernalgorithmen, bei denen einem Modell eine Reihe von Trainingsbeispielen wie Bilder und eine Reihe entsprechender Bezeichnungen wie „Katze“ oder „Hund“ gegeben werden und es lernt, neue, unsichtbare Bilder zu kennzeichnen .

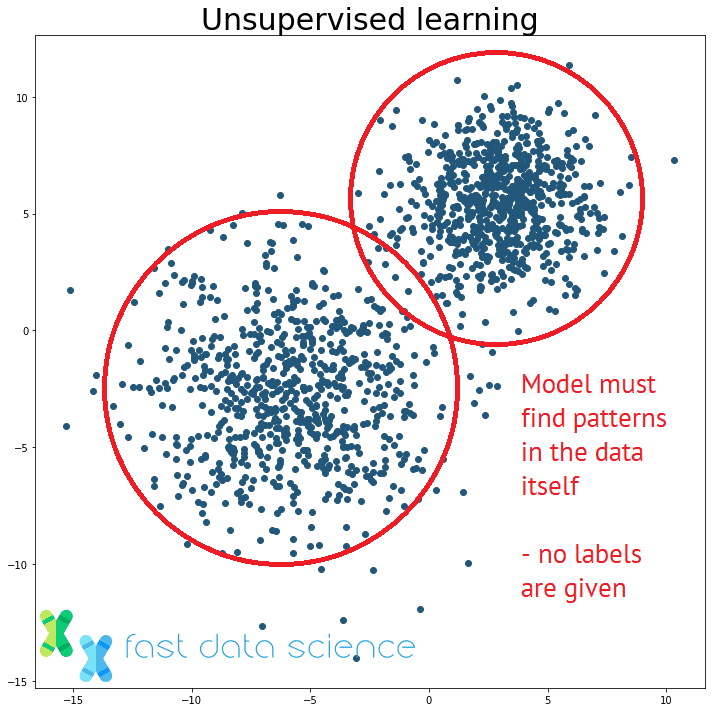

Der Unterschied zwischen überwachtem und unüberwachtem Lernen: Ein unüberwachtes Lernmodell muss Muster in unstrukturierten Daten finden, ohne dass ihm die richtigen Antworten gesagt werden.

Unüberwachtes Lernen ist ein Überbegriff für Algorithmen des maschinellen Lernens, die keine Etiketten verwenden, sondern lediglich nach Mustern in den Daten suchen. Einfache Beispiele für unbeaufsichtigte Lernalgorithmen sind Clustering-Algorithmen wie K-Means-Clustering oder Latent Dirichlet Allocation (LDA).

Ein Beispiel für überwachtes Lernen wäre ein Modell, das eingehende E-Mails zur Sortierung an die Beschwerde- oder Vertriebsabteilung klassifiziert, basierend auf der Entscheidung eines Menschen für frühere E-Mails.

Das entsprechende Problem beim unüberwachten Lernen wäre: Wir erhalten ein Paket nicht klassifizierter E-Mails und haben keine Ahnung, ob sie in zwei oder zehn Gruppen gruppiert werden sollen, und wir haben keine Ahnung, um welche Gruppen es sich handelt. Ein unüberwachter Lernalgorithmus müsste Cluster und Themen selbst entdecken.

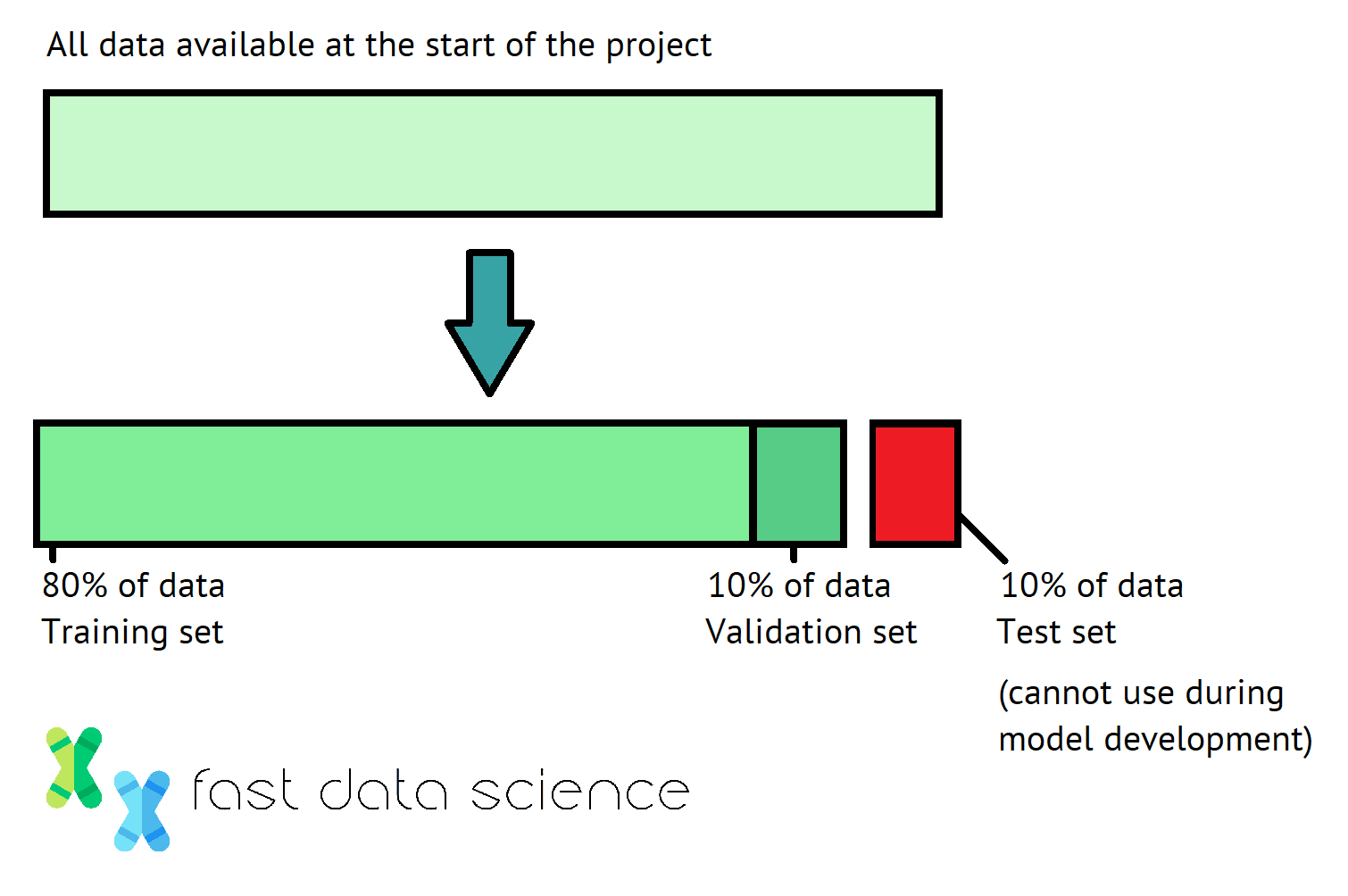

Wenn Sie ein Modell für maschinelles Lernen trainieren, ist es wichtig, normalerweise zwischen Ihrem Trainingssatz, Validierungssatz und Testsatz zu unterscheiden. Aber was ist der Unterschied zwischen dem Validierungssatz und dem Testsatz und warum benötige ich beide?

Stellen Sie sich das wie einen Schüler vor, der für eine große Prüfung über Analysis lernt:

Wenn wir ein Modell für maschinelles Lernen trainieren, nehmen wir normalerweise alle verfügbaren Daten und teilen sie zu Beginn in die Trainings-, Validierungs- und Testsätze auf, oft mit Anteilen von 80-10-10 Prozent. Wir sollten für alle Experimente, die wir anschließend durchführen, die gleiche Aufteilung beibehalten.

Die 80-10-10-Prozent-Aufteilung, die üblicherweise für Trainings-, Validierungs- und Testdaten in der Datenwissenschaft verwendet wird.

Wir können das Trainingsset beliebig nutzen. Sie können beispielsweise mit 1001 verschiedenen Modellen experimentieren, von Faltungs-Neuronalen Netzen bis hin zu LSTMs, um zu sehen, welches Design zu funktionieren scheint. Sie können einen Blick auf das Trainingsset werfen, um zu verstehen, welche Beispiele Ihr Modell falsch macht – hat es beispielsweise Probleme mit dunklen Bildern oder auf dem Kopf stehenden Hunden und Katzen?

Der Validierungssatz sollte strenger verwendet werden. Während wir jedes Modell trainieren, sollten wir die Leistung des Validierungssatzes überwachen. Wir können Hyperparameter wie die Lernrate anpassen, um zu sehen, ob dies die Modellleistung im Validierungssatz verbessert. Aber wir sollten uns nicht im Detail mit den Fehlern des Modells befassen.

Beachten Sie, dass, wenn wir keinen Validierungssatz hätten, das Risiko einer Überanpassung des Modells an den Trainingssatz bestünde. Wenn Sie den Validierungssatz zu oft verwenden, ist es tatsächlich auch möglich, dass Ihr Modell zu stark an den Validierungssatz angepasst wird. Daher halten einige Forscher Ersatzvalidierungssätze bereit, um dieses Problem zu vermeiden. Dies ist natürlich nur dann eine Option, wenn Sie sehr viele Daten haben.

Schließlich sollte der Testsatz nur einmal verwendet werden: wenn wir mit dem gesamten Training fertig sind und bereit sind, das Modell bereitzustellen oder einzureichen. Wenn Ihr Modell beispielsweise in freier Wildbahn eingesetzt wird, um das Kundenverhalten vorherzusagen, dann ist Ihr Testsatz das Verhalten echter Kunden in der Zukunft.

Eine nützliche Technik ist die Kreuzvalidierung , bei der die Trainingsdaten und Validierungsdaten rotiert werden und jede Instanz mindestens einmal sowohl als Trainings- als auch als Testdaten verwendet wird. Die Kreuzvalidierung ist nützlich, weil sie uns zeigt, wie gut sich ein Modell auf neue Daten verallgemeinern lässt.

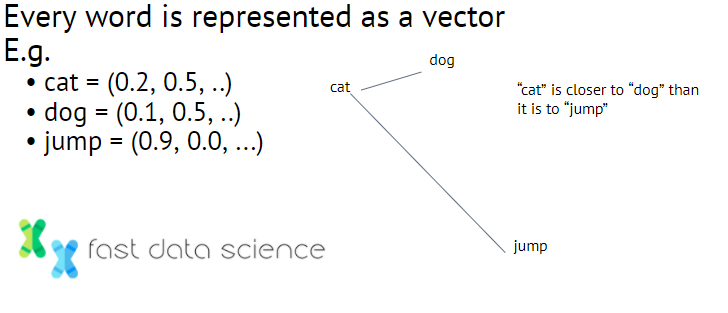

Wortvektoreinbettungen sind eine Technik, die bei der Verarbeitung natürlicher Sprache verwendet wird und bei der Wörter Vektoren reeller Zahlen zugeordnet werden. Zum Beispiel:

Einige Beispiele, wie Wortvektor-Einbettungen aussehen könnten. Ein weiteres klassisches Beispiel ist „Mann“ in der Nähe von „Frau“ und „König“ in der Nähe von „Königin“. Sie können also sogar Vektoren subtrahieren, um „König“ + „Frau“ zu erhalten – „Mann“ = „Königin“.

Oft wird ein großer Raum verwendet, beispielsweise der in word2vec verwendete 300-dimensionale Vektorraum.

Es besteht eine semantische Ähnlichkeit zwischen Wörtern, die im Vektorraum nahe beieinander liegen. Unten finden Sie eine Word2vec-Einbettung, die ich anhand einer Reihe von Stellenbeschreibungen trainiert habe.

Eine Wortvektor-Einbettung, die auf einem Datensatz mit Text-Stellenbeschreibungen trainiert wurde. Beachten Sie, dass Markt, Branche und Sektor eng beieinander liegen. Dies ist eine Form des unbeaufsichtigten Lernens.

Der Vorteil der Verwendung von Wortvektoreinbettungen besteht darin, dass Wörter in natürlicher Sprache in ein neuronales Netzwerk eingespeist werden können, wodurch wir Deep Learning nutzen können, um im Grunde eine Art diskrete Daten zu verarbeiten.

Erklärbare KI ist eine Reihe von Techniken zur Analyse und Zerlegung von Modellen des maschinellen Lernens. Einige Deep-Learning-Modelle verfügen über Millionen von Parametern und es ist für einen Menschen nicht möglich zu verstehen, was sie alle tun. Mit erklärbarer KI führen wir kleine Störungen in die Eingabe eines Modells ein und beobachten, wie sie sich auf die Ausgabe des Modells auswirken. Indem Sie dies mehrmals tun, können Sie verstehen, warum ein Modell bestimmte Entscheidungen trifft.

Erklärbare KI dürfte an Bedeutung gewinnen, da die KI-Regulierung beginnt, Erklärungen für algorithmische Entscheidungen zu verlangen.

Hier ist ein kurzes Video, das wir bei Fast Data Science über erklärbare KI gemacht haben.

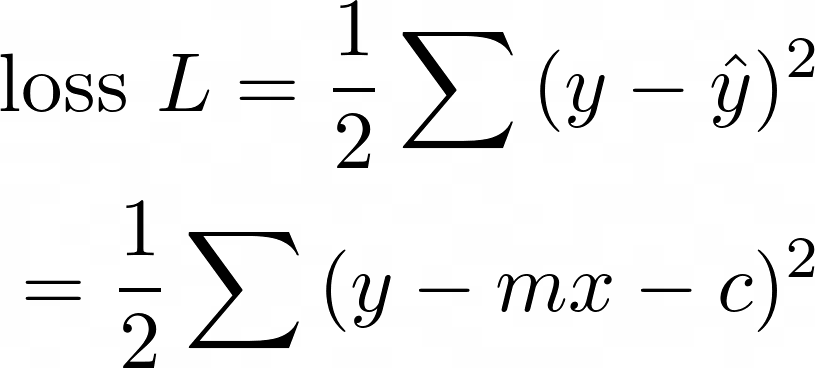

Diese Formel liegt der linearen Regression und damit auch neuronalen Netzen und einem Großteil der Datenwissenschaft zugrunde. Haben Sie sich jemals gefragt, wie Microsoft Excel es schafft, eine gerade Linie an eine Reihe verstreuter Punkte anzupassen?

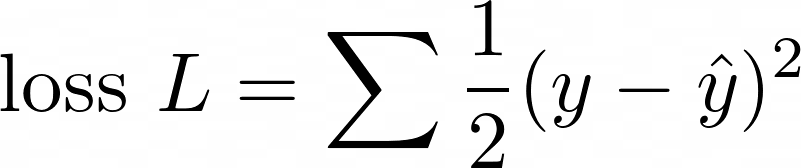

Die Antwort lautet durch Minimierung der Gesamtverlustfunktion ½( y - ŷ )² für alle Datenpunkte:

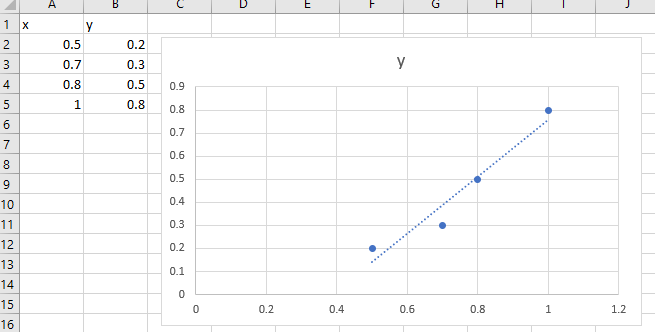

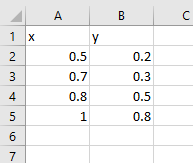

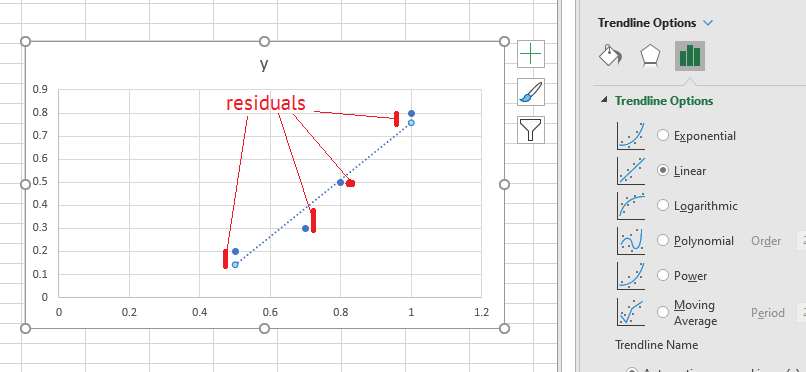

Stellen wir uns vor, unser Datensatz besteht aus einer Reihe von Punkten x und y :

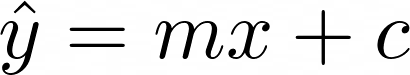

Wir möchten ein Modell so trainieren, dass es zu einer Linie passt

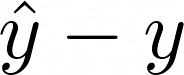

Wenn die Punkte nicht genau auf einer geraden Linie liegen, beträgt der Fehler an jedem Punkt

Dies wird als Residuum bezeichnet.

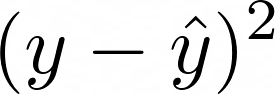

Wie kann man den Rest so klein wie möglich machen? Die Mathematik ist einfacher, wenn wir versuchen, das Quadrat des Residuums zu minimieren:

Dazu setzen wir ½ voran, um das Ergebnis schöner zu machen, und bilden die Summe der Residuen aller Datenpunkte. Wir nennen dies die Verlustfunktion:

Wenn Excel nun eine gute Anpassung gefunden hat, ist die Verlustfunktion gering. Dies geschieht, wenn der Gradient der Verlustfunktion gleich Null ist. Es ist möglich, die richtigen Werte für m und c auszuwählen, um die Verlustfunktion auf den niedrigstmöglichen Wert zu bringen. Das ist es, was Excel unter dem Deckmantel tut: Es minimiert den Abstand von jedem Punkt in den Daten zur Linie der besten Anpassung.

Jetzt können wir KI und Datenwissenschaft entmystifizieren.

Was ist ein tiefes neuronales Netzwerk? Es handelt sich lediglich um eine Reihe von Excel-ähnlichen linearen Regressionsmodellen, die mit Aktivierungsebenen (z. B. der Sigmoidkurve ) zusammengeklebt sind. Um den niedrigsten Wert der Verlustfunktion zu erhalten, ist noch ein weiteres Geheimnis erforderlich: der Backpropagation-Algorithmus . Lesen Sie mehr dazu in meinem Beitrag zum Thema „Wie neuronale Netze lernen“ .

Wenn also Unternehmen, die KI-Lösungen verkaufen, darüber reden, wie „intelligent“ ihre neuronalen Netze sind und wie sie eine KI geschaffen haben, die besser Drehbücher schreiben kann als ein Mensch oder besser malen kann als Picasso, dann ist das nur ein Marketing-Hype. Was diese Unternehmen wirklich haben, ist Folgendes:

Pseudodiagramm eines neuronalen Netzwerks aus Excel, das die Aktion „Eine Linie an Daten anpassen“ darstellt.

Obwohl ich die Weltuntergangsängste mancher Menschen vor der Übernahme der Weltherrschaft durch eine böswillige KI nicht herunterspielen möchte, scheint es mir, dass die modernsten KIs von heute denselben Fischbestand darstellen wie die grundlegende Excel-Zeilenanpassungsfunktion … nur ein paar clevere Tricks.

Allerdings hat uns allein dieses Jahr gezeigt, wie plötzlich Katastrophen auftreten können, sodass ich im Jahr 2021 möglicherweise meine Worte fressen werde!

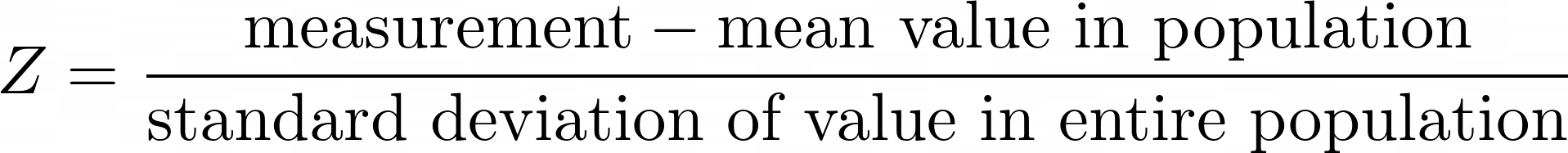

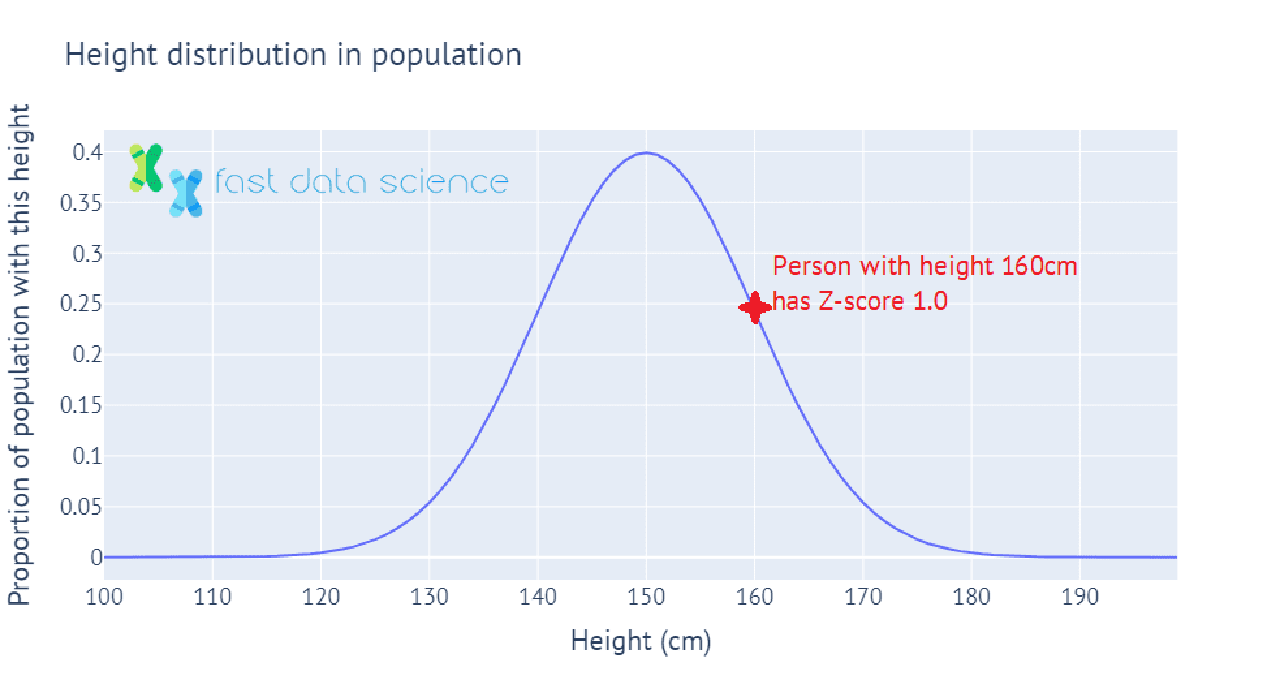

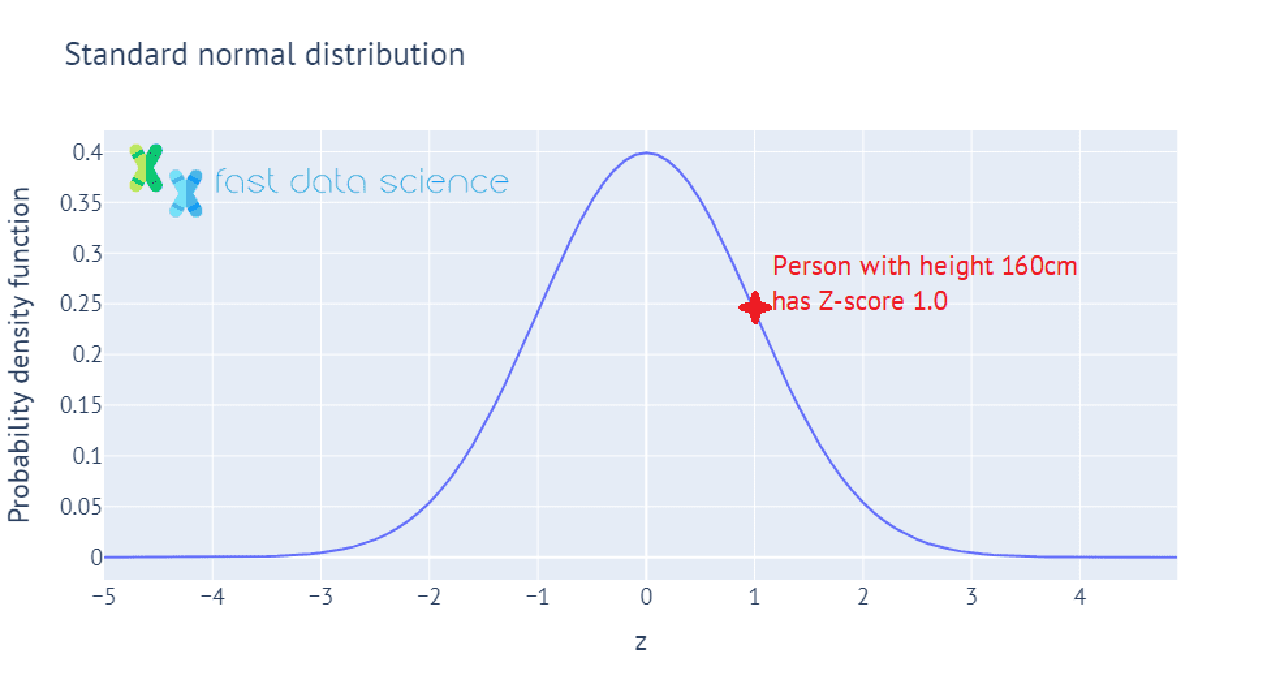

Der Z-Score oder Standard-Score ist ein Wert, der angibt, um wie viele Standardabweichungen über oder unter dem Mittelwert eine Messung liegt. Wenn die Bevölkerung eines Landes beispielsweise eine mittlere Körpergröße von 150 cm und eine Standardabweichung von 10 cm hat, dann hätte eine Person mit einer Körpergröße von 150 cm einen Z-Score = 0 und eine Person mit einer Körpergröße von 160 cm hätte einen Z-Score von 1.

Hier ist eine interaktive Darstellung, wie Körpergrößen in der Bevölkerung auf Z-Scores abgebildet werden können. Sie zeigt, wie wir den Z-Score für eine Person berechnen, deren Körpergröße eine Standardabweichung über der durchschnittlichen Körpergröße in der Bevölkerung liegt:

In der Statistik haben wir in der Praxis oft nur eine Stichprobe an Daten, etwa 100 Personen, deren Körpergröße wir gemessen haben. In diesem Fall kennen wir den Mittelwert und die Standardabweichung der Körpergröße der Grundgesamtheit nicht und verwenden stattdessen den Mittelwert und die Standardabweichung der Stichprobe von 100. Dieser Wert wird als t -Statistik bezeichnet und wir können damit viele statistische Tests durchführen, beispielsweise um die Hypothese zu testen, dass sich die durchschnittliche Größe der Männer in der Bevölkerung erheblich von der durchschnittlichen Größe der Frauen in der Bevölkerung unterscheidet.

Werte wie der Z-Score und die t -Statistik werden häufig von Statistikern verwendet, kommen aber bei maschinellen Lern- und Datenwissenschaftsproblemen selten vor, da es bei vielen maschinellen Lern- und Datenwissenschaftsanwendungen in der Industrie darum geht, Vorhersagen zu treffen, z. B. über das Verhalten von Kunden oder Maschinen Ausfall, Fahrzeugbeladung und dergleichen, statt c. Hypothesentests werden jedoch häufig in Bereichen wie der Pharmaindustrie eingesetzt, wo ein Unternehmen beispielsweise verlangen könnte, dass ein neues Medikament mit einem Konfidenzniveau von 5 % wirksam ist.

Suchen Sie Experten in Natürlicher Sprachverarbeitung? Veröffentlichen Sie Ihre Stellenangebote bei uns und finden Sie heute Ihren idealen Kandidaten!

Veröffentlichen Sie einen Job

Mittlerweile sind es Organisationen aller Größenordnungen und fast aller Sektoren werden zunehmend datengesteuert, insbesondere als größere Datenspeicher Systeme und schnellere Computer treiben die Leistungsgrenzen immer weiter voran.

Aufgrund des umfangreichen Einsatzes von Technologie und der Arbeitsteilung hat die Arbeit des durchschnittlichen Gig-Economy-Arbeiters jeden individuellen Charakter und damit auch jeden Charme für den Arbeitnehmer verloren.

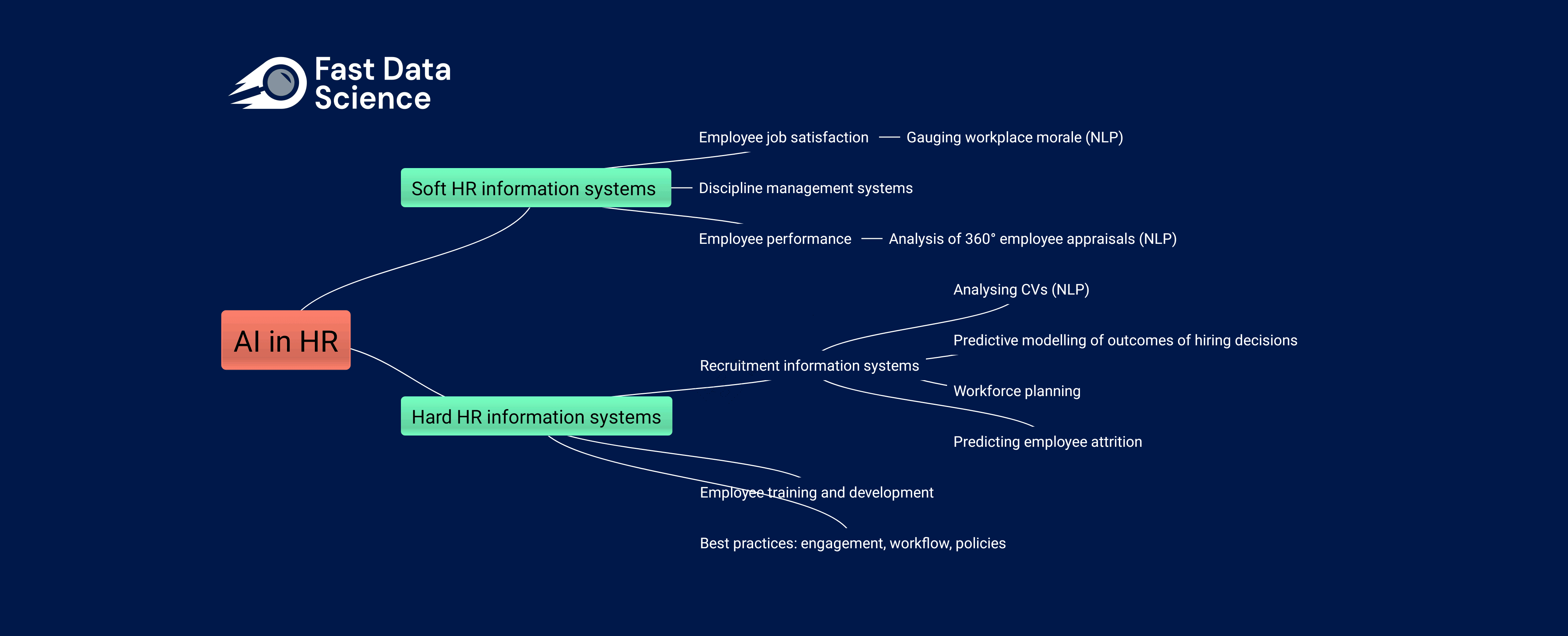

Die Auswirkungen von KI auf die Humanressourcen Die Arbeitswelt verändert sich rasant, sowohl aufgrund der Einführung traditioneller Data-Science-Praktiken in immer mehr Unternehmen als auch aufgrund der zunehmenden Beliebtheit generativer KI-Tools wie ChatGPT und Googles BARD bei nicht-technischen Arbeitnehmern.

What we can do for you