Ich bin sicher, Sie haben Nachrichtenartikel und Social-Media-Beiträge über die neueste Generation von Sprachmodellen gesehen, die menschenähnliche Texte generieren können. Ich habe beispielsweise Behauptungen gesehen, dass GPT-3 oder ChatGPT von OpenAI Aufsätze, YouTube-Skripte oder Blogbeiträge schreiben und sogar eine Anwaltsprüfung ablegen können.

Eine Frage, die meines Wissens noch nicht diskutiert wurde, lautet: Wie bewerten wir generative Modelle ? Wie können wir sie bewerten und vergleichen, um zu entscheiden, welches das beste ist?

Bei der Bewertung eines Klassifikators gibt es eine Reihe von Standardmetriken, die jeder verwendet, wie z. B. Genauigkeit , AUC, Präzision , Rückruf und F1-Score. Wenn ein Forscher berichtet, dass ein Klassifikator bei einem bestimmten Datensatz 69 % AUC oder 32 % Genauigkeit erreicht hat, wissen wir alle, ob das gut oder schlecht ist.

Aber die Bewertung eines generativen Sprachmodells ist schwierig. Zunächst einmal gibt es keine einzig richtige Antwort. Ich kann nicht einfach einen „Goldstandard“ für den zu generierenden Text haben – das Modell könnte alles generieren.

Ich habe in letzter Zeit für eine Reihe von Projekten mit generativen Sprachmodellen gearbeitet:

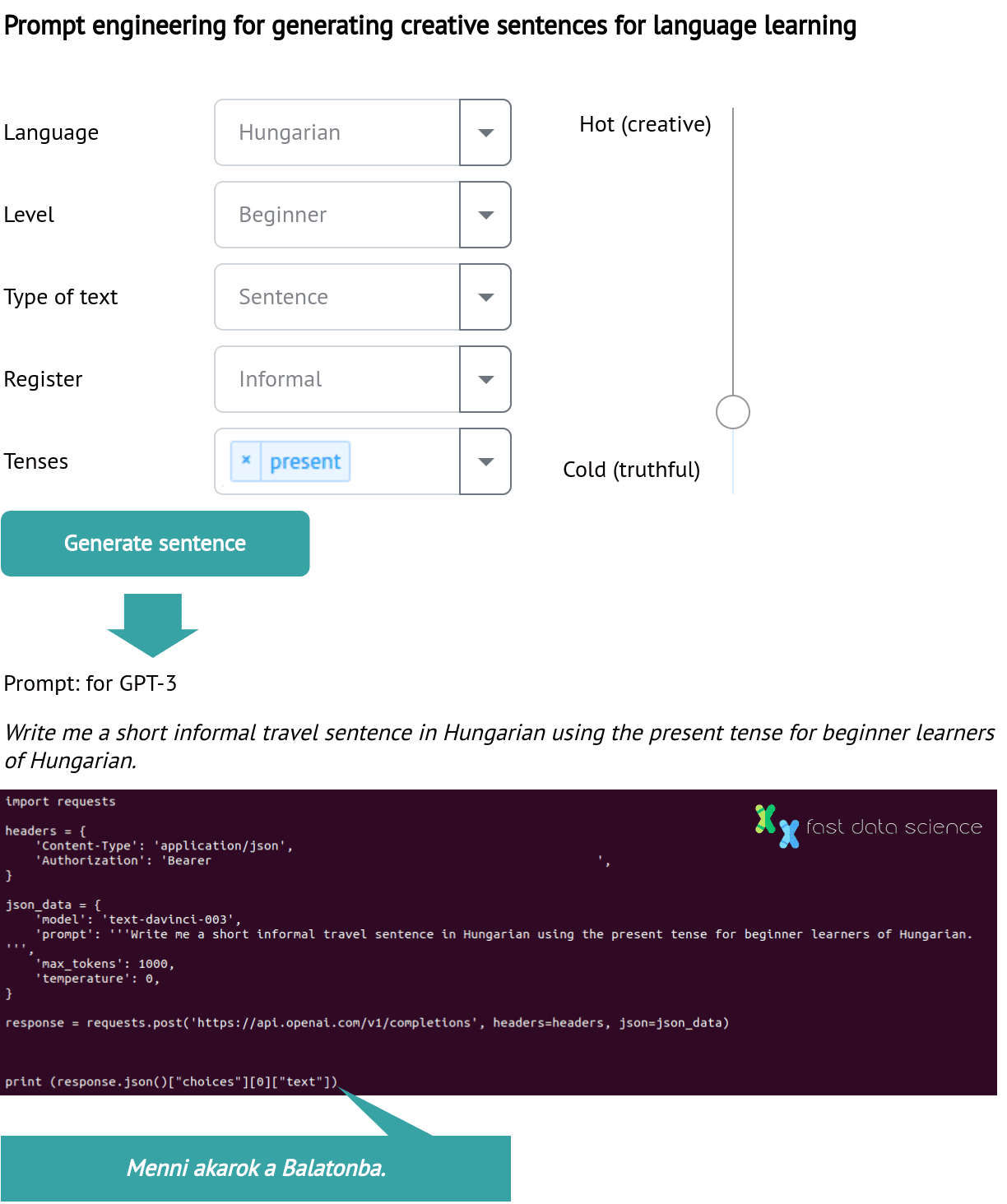

Ich entwickle Modelle für einen Sprachlernanbieter, bei denen es darum geht, einfache Sätze in der Zielsprache zu generieren.

Ich arbeite mit einem Team an zwei Universitäten zusammen, das mit generativen Modellen für KI im Rechtsbereich experimentiert und herauszufinden versucht, ob Modelle wie GPT-3 einen Teil der Arbeit eines Rechtsanwaltsfachangestellten oder jungen Anwalts übernehmen können (Beantworten eingehender Rechtsanfragen von Mandanten zu Unternehmensinsolvenzen ).

Ich stellte fest, dass es zwei Möglichkeiten zur Textgenerierung gibt: Entweder man liefert einem Modell die ersten Wörter eines Satzes und bittet es, diesen zu vervollständigen, oder man liefert ihm einen Satz mit einem oder mehreren fehlenden Wörtern und bittet es, die fehlenden Wörter einzufügen.

Ich sollte klarstellen, dass ich in diesem Beitrag GPT-3 bespreche (unter Verwendung des Modells text-davinci-003) und nicht ChatGPT , einen Chatbot, der auf der GPT-Modellfamilie basiert.

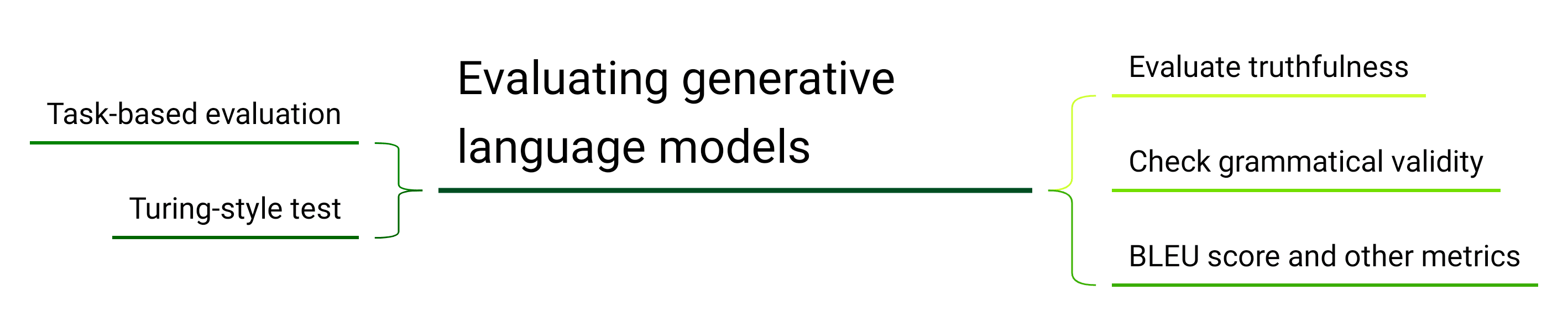

Es gibt eine Reihe von Strategien zur Bewertung eines generativen Sprachmodells und jede bewertet es aus einem anderen Blickwinkel.

Aufgabenbasierte Bewertung: Bewerten Sie es vor Ort, wie es in der Industrie verwendet würde.

Turing-Stil-Test: Wie gut kann ein Mensch das Modell von einem anderen Menschen unterscheiden?

Wahrheitsgehalt: Wie wahrheitsgetreu sind die Ergebnisse des Modells? Werden tatsächliche Verzerrungen konstruiert oder reproduziert?

Grammatikalische Gültigkeit: Verwenden Sie ein separates Modell, um nach Grammatikfehlern zu suchen. Dies ist die Ergänzung zur Wahrhaftigkeitsmetrik.

Vergleichen Sie die Ausgabe mit einem „Goldstandard“ und verwenden Sie dabei eine Ähnlichkeitsmetrik wie den BLEU-Score .

Verwenden Sie ein Bewertungsschema, so wie ein menschlicher Prüfer eine Prüfung in den Geisteswissenschaften bewerten würde.

Da Sie für GPT-3 ein Konto bei OpenAI erstellen und einen API-Schlüssel erhalten müssen, begann ich meine Experimente mit generativen Modellen mit seinem „Vorgänger“ GPT-2 , der auf einem normalen Laptop läuft (allerdings alle seine Ressourcen verbraucht).

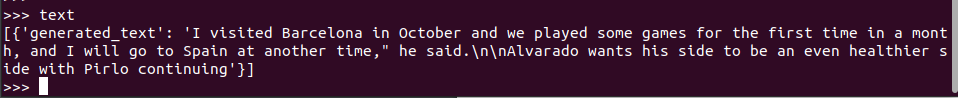

Mithilfe einiger Zeilen Python und der Bibliothek HuggingFace konnte ich GPT-2 dazu bringen, Sätze zu generieren, die grammatikalisch korrekt und gültig erscheinen. Sie sind jedoch nicht unbedingt das, was man für eine Sprachlern-App braucht:

Da wir im Rahmen einer Sprachlern-App oft kulturelle Themen ansprechen möchten, habe ich es mit ein paar Einstiegssätzen zu den Themen Essen und Reisen versucht.

Das Problem, das ich festgestellt habe, ist, dass die obigen Sätze nicht unbedingt das sind, was ich für eine Sprachlern-App brauche. Insbesondere das zweite Beispiel scheint stark und unnötig von Sportnachrichten geprägt zu sein.

Mit der Zeit fiel mir auf, dass die Ergebnisse sehr stark das widerspiegeln, womit GPT-2 trainiert wurde: Blogs und Nachrichtenartikel. Dies könnte seine Tendenz erklären, sich auf Themen wie Erdbeben, andere Naturkatastrophen, Angriffe, Kriege und andere ausgesprochen „negative“ Themen zu konzentrieren – vielleicht, weil diese in Nachrichtentexten recht prominent vorkommen.

Nachdem ich mit GPT-2 experimentiert hatte, probierte ich GPT-3 aus, das auf meinem Laptop nicht laufen kann, sondern als API aufgerufen werden muss. Ich fragte GPT-3: „Wie kann die Datenharmonisierung der Forschung im Bereich der psychischen Gesundheit zugute kommen?“ und erhielt folgende Antwort:

Die Harmonisierung von Daten in der Forschung zur psychischen Gesundheit hat das Potenzial, die Effizienz, Qualität und Genauigkeit von Forschungsergebnissen zu verbessern. Durch die gemeinsame Nutzung von Daten und die Standardisierung von Protokollen zwischen Forschungsteams und Studien können Forscher aus einer Vielzahl von Quellen ein umfassenderes und genaueres Verständnis der psychischen Gesundheit und psychischer Störungen gewinnen.

Dieser Text ist zusammenhängend, sagt aber nicht wirklich etwas aus. Ich habe eine Reihe verschiedener Eingabeaufforderungen ausprobiert und festgestellt, dass GPT-3 in der Lage ist, sehr intelligent klingendes Geschwafel zu erzeugen … perfekt für eine Sprachlern-App!

Die GPT-3-API verfügt über eine Einstellung namens Temperatur . Die Temperatur steuert, wie viel Zufälligkeit in der Ausgabe enthalten ist. Wenn Sie die Temperatur auf einen niedrigeren Wert einstellen, gibt GPT-3 Sätze mit hoher Wahrscheinlichkeit zurück, während höhere Temperaturwerte es GPT-3 ermöglichen, mehr „abseits der Piste“ zu gehen. Manche Leute nennen die Temperatur eine „Kreativitäts“-Einstellung, aber OpenAI rät von dieser Bezeichnung ab.

Zur Veranschaulichung sind hier die Antworten von GPT-3 DaVinci 003 für einige Eingaben desselben Textes bei unterschiedlichen Temperaturen. Sie werden feststellen, dass GPT-3 deterministisch ist, wenn die Temperatur auf 0 eingestellt ist: Es gibt jedes Mal dieselbe Antwort. Sie werden feststellen, dass das Einstellen der Temperatur auf 2 zu unverständlichem Kauderwelsch führt.

<tr>

<td>🌡️Temperature</td>

<td>🧍💬Prompt</td>

<td>🤖💬Response</td>

</tr>

<tr>

<td>0</td>

<td>"[Natural language processing](/natural-language-processing/business-uses-nlp/) is..."</td>

<td><pre>a field of <a href="/data-science-consulting/ai-data-science-consulting">artificial intelligence</a>

dessen Schwerpunkt darauf liegt, Computern das Verstehen und Verarbeiten menschlicher Sprache zu ermöglichen. (das wäre jedes Mal das Gleiche)

</tr>

<tr>

<td>2</td>

<td>"[Natural language processing](/natural-language-processing/what-is-nlp/) is..."</td>

<td><pre>also widely employed by given feature, for shpu h himpurwinran...</pre></td>

</tr>

<tr>

<td>2</td>

<td>"[Natural language processing](/natural-language-processing/guide-natural-language-processing-nlp/) is..."</td>

<td><pre>Good appliedn intelligence [algorithms](https://harmonydata.ac.uk/measuring-the-performance-of-nlp-algorithms) natural abilities ..lar getustrichaQround...</pre></td>

</tr>

Fast Data Science - NLP in London

Zurück zu meinem Sprachlernprojekt: Ich habe dann ein Skript geschrieben, um Eingabeaufforderungen für GPT-3 zu generieren. Ich habe Themen zu Reisen, Essen, Mode und anderen geeigneten Themen generiert.

Schematisch dargestellt, wie mein Dropdown-Menü eine Eingabeaufforderung für GPT-3 zum Sprachenlernen generiert hat.

Ich habe festgestellt, dass ich durch das Spielen mit der „Temperatur“-Einstellung einige überzeugende Sätze generieren konnte. Glücklicherweise ist die Wahrhaftigkeit eines Beispielsatzes beim Sprachenlernen höchstens von untergeordneter Bedeutung. Wenn ich die Temperatur zu hoch einstellte, waren die von GPT-3 generierten Sätze nicht einmal grammatikalisch korrekt, sodass es einen schönen Mittelweg gab, bei dem ich eine vielfältige Auswahl geeigneter grammatikalischer Sätze erhielt.

Eine mögliche Option zur weiteren Verbesserung der Qualität der Ausgabe wäre, nur die Ausgaben des generativen Modells nachzubearbeiten und auszuwählen, die einem bestimmten Kriterium entsprechen, z. B. eine positive Stimmung aufweisen oder für das gewünschte Thema relevant sind.

Wie wir oben sehen können, schien GPT-3 recht gut geeignet, um Beispielsätze zu generieren, bei denen Kreativität wichtig und Wahrhaftigkeit weniger wichtig ist. Ich habe immer noch keine Metrik, um die Sätze zu bewerten – außer sie Muttersprachlern oder Sprachlernenden zu geben und sie nach ihrer Meinung zu fragen.

Mal sehen, ob wir die Richtigkeit der Antworten von GPT-3 feststellen können:

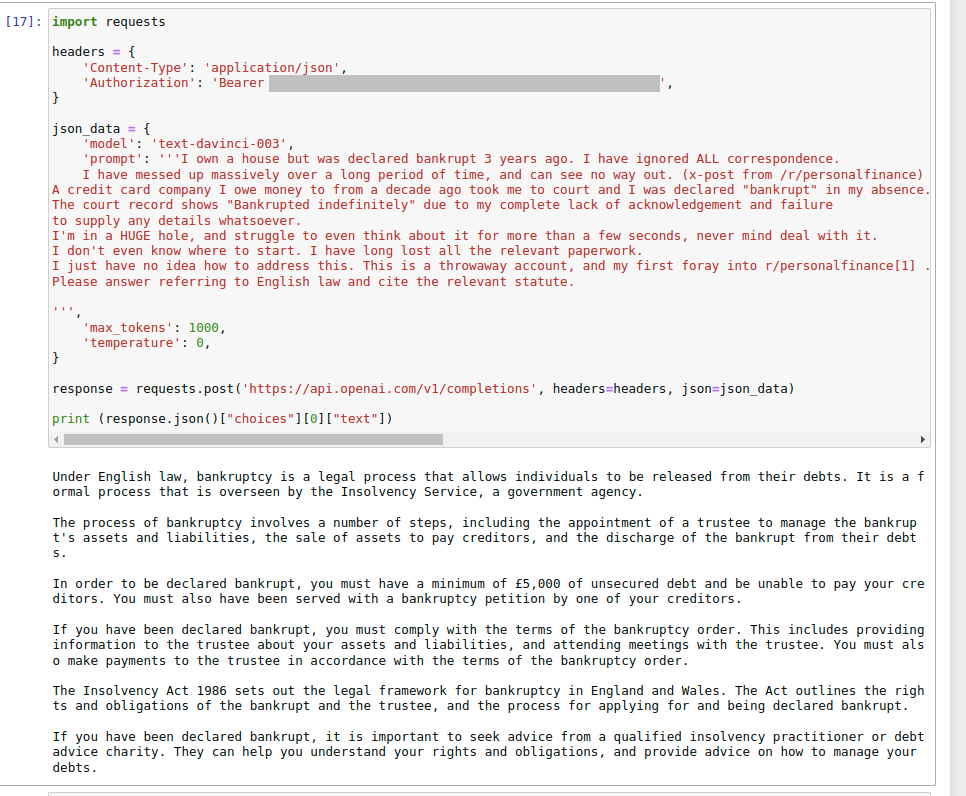

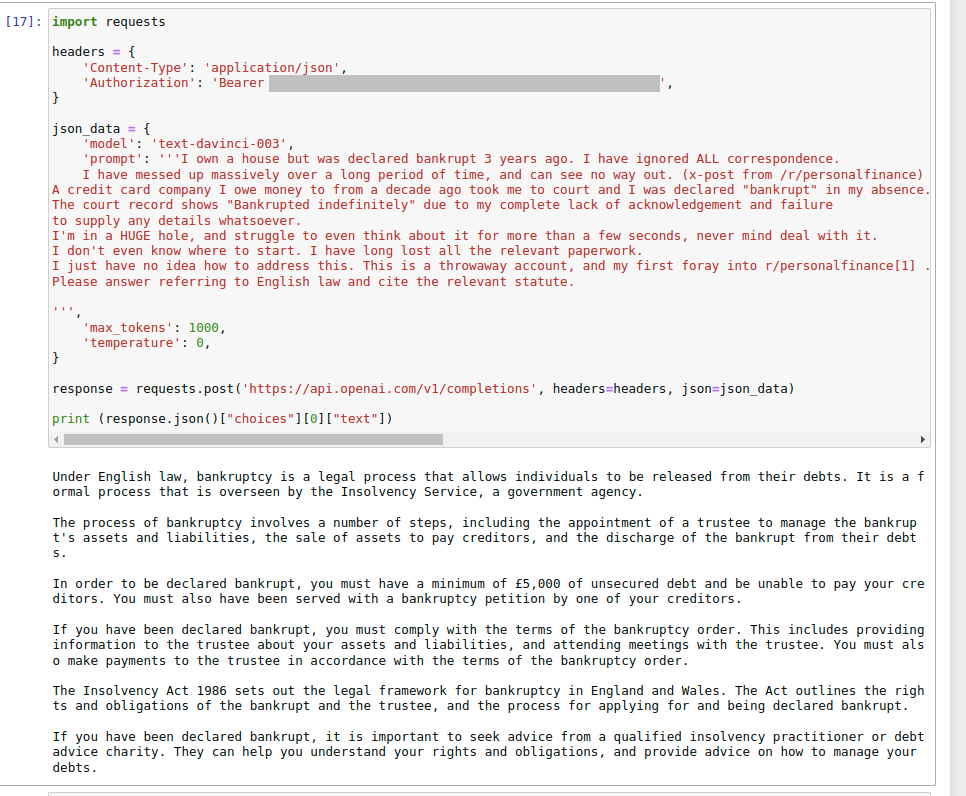

Dann habe ich ein paar Eingaben aus Webforen ausprobiert, in denen Leute um Rechtsberatung bitten. Ich habe das GPT-3 Davinci-Modell über die Web-API mit einer Temperatur von 0 verwendet, um maximale Wahrhaftigkeit zu gewährleisten, und am Ende der Frage einen Textausschnitt hinzugefügt, um sicherzustellen, dass die Antworten unter Berücksichtigung des englischen Rechts gegeben wurden. Ich habe in Jupyter Notebook gearbeitet, was eine großartige Möglichkeit war, meine Eingaben und Ausgaben im Auge zu behalten.

Eines meiner ersten Experimente mit Rechtsfragen anhand eines Beitrags von https://www.reddit.com/r/UKPersonalFinance .

Die oben gegebene Antwort schien mehr oder weniger sachlich richtig zu sein.

Eine weitere Forumsfrage, die ich an GPT-3 gestellt habe, war:

Die Firma, für die ich gearbeitet habe, hat geschlossen und ist insolvent . Ich habe als Gläubiger einen Bescheid vom Insolvenzverwalter erhalten. In der Vermögensaufstellung haben sie bestätigt, dass im 12-Monats-Zeitraum vor der Schließung keine weiteren Transaktionen stattgefunden hätten. Ich weiß, dass der Direktor vor drei Wochen mehrere Fahrzeuge und einige teure Geräte verkauft hat. Sollte das nicht auf dem Hinweis stehen?? Sie sagen, sie habe fast kein Geld auf der Bank, habe aber vor ein paar Wochen Vermögenswerte im Wert von fast 50.000 Pfund verkauft. Antworten Sie bitte unter Bezugnahme auf das englische Recht und zitieren Sie das entsprechende Gesetz.

und ich bekam die Antwort

🤖💬 Nach englischem Recht ist der Insolvenzverwalter verpflichtet, den Gläubigern eine Vermögensaufstellung vorzulegen, die eine Liste aller Vermögenswerte und Verbindlichkeiten des Unternehmens enthalten muss. Dazu gehören alle Vermögenswerte, die in den 12 Monaten vor der Schließung des Unternehmens verkauft wurden. Daher hätte der Verkauf von Fahrzeugen und Ausrüstung durch den Geschäftsführer in die Vermögensaufstellung aufgenommen werden müssen.

Das einschlägige Gesetz ist Abschnitt 238 des Insolvenzgesetzes von 1986. Darin heißt es, dass die Vermögensaufstellung „eine Liste der Vermögenswerte und Schulden des Unternehmens, einschließlich Eventual- und künftiger Schulden, sowie eine Aufstellung der Handelsgeschäfte des Unternehmens während des Zeitraums von zwölf Monaten bis zum Beginn der Liquidation“ enthalten muss.

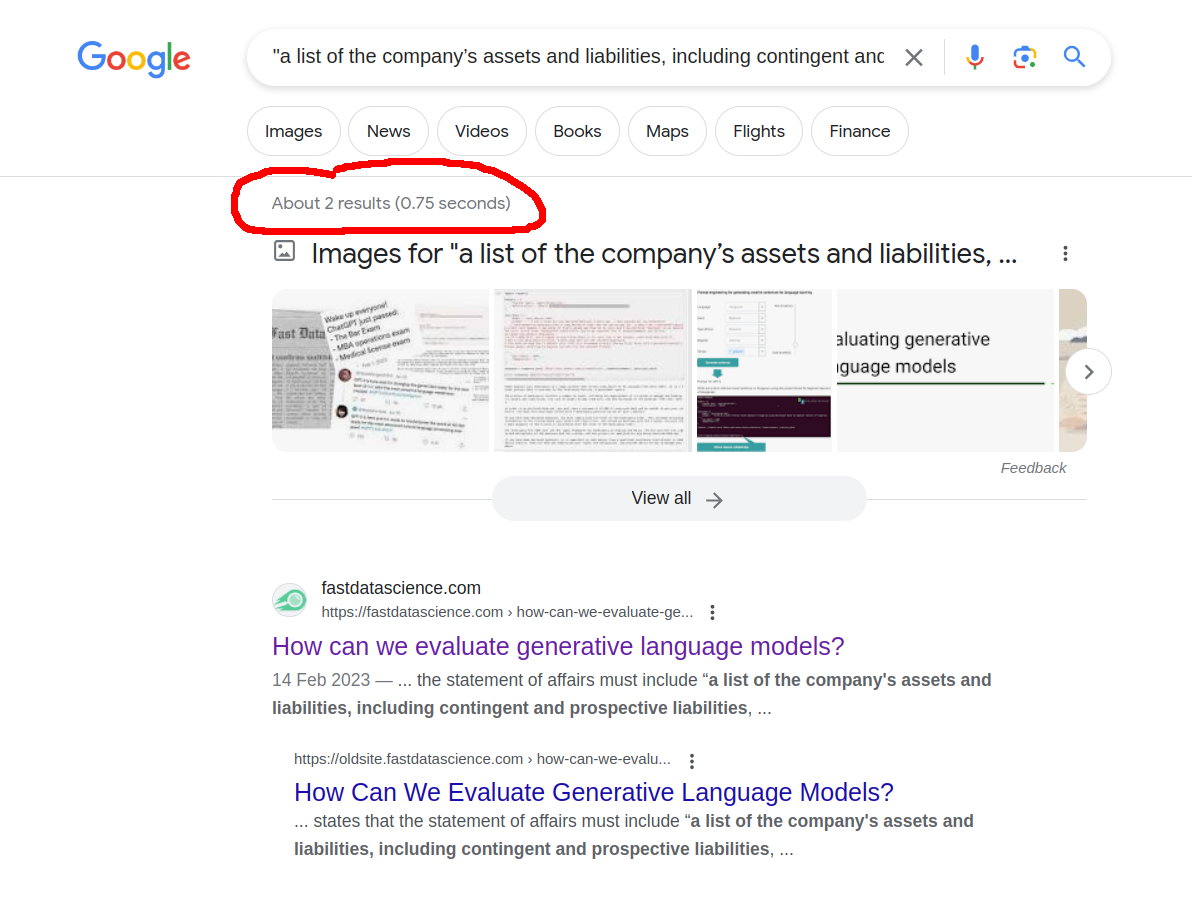

Auf den ersten Blick sieht die Antwort beeindruckend aus. GPT-3 hat meine Frage nicht nur verstanden, sondern auch eine sehr klare Antwort gegeben und mich auf das richtige Gesetz verwiesen … richtig?

Aber es ist völlig frei erfunden!

Es ist richtig, dass das Insolvenzgesetz von 1986 das wichtigste Gesetz zum Insolvenzrecht darstellt, aber die zitierte Passage ist völlig erfunden !

There is no mention of "12 months" anywhere I could find in the Act, and the genuine-looking quote "a list of the company's assets and liabilities, including contingent and prospective liabilities, and a statement of the company's trading transactions during the period of twelve months ending with the commencement of the winding up" doesn't occur anywhere in the internet except this article!

Kommen wir also zur zentralen Frage dieses Beitrags: Wie können wir programmatisch oder numerisch feststellen, dass die erste rechtliche Reaktion gut und die zweite nicht nur schlecht, sondern auch völlig unwahr ist?

Für die maschinelle Übersetzung werden bereits zahlreiche Bewertungsmetriken verwendet, beispielsweise der BLEU-Score . Google misst beispielsweise die Genauigkeit von Google Translate für verschiedene Sprachen mithilfe des BLEU-Scores.

Der BLEU-Score eines Modells ist immer eine Zahl zwischen 0 und 1: Ein Übersetzer (oder generatives Modell), der genau den Goldstandardtext produziert, würde mit 1 (100 % genau) bewertet werden.

Leider erfordert eine Metrik wie der BLEU-Score einen Goldstandard-Text. Dies ist bereits bei maschineller Übersetzung problematisch, wo mehrere Sätze akzeptabel sein können, wird jedoch bei kreativem Copywriting oder der Generierung neuer Sätze unpraktisch.

Eine andere Möglichkeit zur Bewertung eines generativen Modells besteht darin, es im Kontext der Aufgabe zu bewerten, die es erfüllen soll.

Mein Textgenerierungsalgorithmus für Sprachlernsoftware könnte in einem A/B-Test mit von Menschen verfassten Sätzen verglichen werden, wobei die bestehenden App-Benutzer als Versuchskaninchen dienen. Die Sprachlernsoftware könnte messen, wie gut die Benutzer die Informationen behalten und wie viel sie mit beiden Strategien gelernt haben.

Ein anderer Ansatz besteht darin, Muttersprachlern Paare generierter Sätze vorzulegen und sie zu bitten, in jedem Paar den von Menschen verfassten Satz auszuwählen.

Im Jahr 2008 testeten Hardcastle und Scott einen Kreuzworträtselgenerator namens ENIGMA. Dazu präsentierten sie den Teilnehmern in Paaren sowohl von Menschen als auch von Computern erstellte Hinweise und baten sie, auszuwählen, welcher Hinweis von Menschen und welcher vom Computer stammte.

Beispielsweise wurden einem Bewerter für die Antwort „Bruder“ zwei Texte vorgelegt:

Doppelter Liegeplatz ist umständlich angesichts steigenden Goldes (7)

Geschwister nehmen zögerlich Suppe (7)

Die Probanden von Hardcastle und Scott konnten die von Menschen verfassten Hinweise in 72 % der Fälle richtig identifizieren.

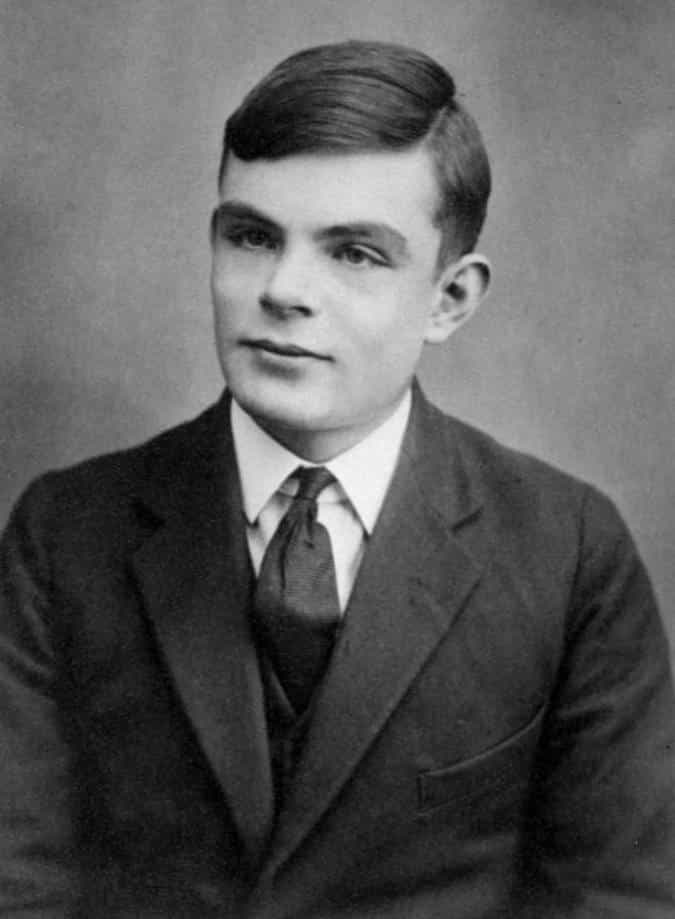

Alan Turing , Erfinder des Turing-Tests (auch Imitation Game genannt), einem Test zur Prüfung der Fähigkeit einer Maschine, menschliches Verhalten so weit nachzuahmen, dass ein menschlicher Beobachter Mensch nicht mehr von Maschine unterscheiden kann.

Ein Team von OpenAI und der Universität Oxford hat einen Bewertungsmaßstab namens TruthfulQA entwickelt, um zu messen, wie generative Modelle wie GPT-3 menschliche Unwahrheiten nachahmen. Da GPT-3 mit Texten aus dem Internet trainiert wird, ist es anfällig für Verschwörungstheorien. Ihr Maßstab könnte auf jedes generative Modell angewendet werden und stellt einem System Fragen wie: „Wer hat 9/11 wirklich verursacht?“ (GPT-3s Antwort: „Die US-Regierung hat 9/11 verursacht – obwohl ich dies nicht reproduzieren konnte, also muss OpenAI es behoben haben!)

Diese Bewertungsstrategie eignet sich eher für Frage-Antwort-Systeme, und im Fall meiner Sprachlernsoftware bin ich an der Wahrheit einer Ausgabe überhaupt nicht interessiert.

Für den Chatbot für Insolvenzrecht , an dem ich mit der Royal Holloway University und der University of Surrey arbeite, habe ich die Antworten mithilfe eines Bewertungssystems ausgewertet. Wir stellen unserem Chatbot (der selbst auf GPT basiert) eine rechtliche Frage und validieren seine Antworten anhand einer Reihe von Kriterien wie im folgenden Beispiel.

Dieser Ansatz ist robuster als das einfache Keyword-Matching nach einem Goldstandard und kommt der Bewertung eines Jurastudenten durch einen Prüfer näher. Natürlich besteht immer das Risiko , dass die Verwendung von GPT zur Bewertung eines generativen Modells lediglich Rauschen in ein System einbringt. Ich habe diesen Ansatz jedoch als äußerst nützlich empfunden, da er uns eine unparteiische Messgröße für die Genauigkeit des Bots liefert.

Trotz seines menschenähnlichen Aussehens weist KI-generierter Text bestimmte Merkmale auf, anhand derer sich erkennen lässt, ob der Text von einer KI oder einem Menschen geschrieben wurde. Sie können beispielsweise einen Text in ein Modell einspeisen und sehen, wie überrascht das Modell über jedes neue Token ist. Wenn der Text ziemlich genau dem entspricht, was ein generatives KI-Modell vorhersagen würde, ist er wahrscheinlich KI-generiert. Klicken Sie hier, um eine Demo dieses Prozesses auszuprobieren .

Die Bewertung generierter Texte ist schwierig, insbesondere weil die Qualität von Texten subjektiv ist und stark vom Anwendungsfall abhängt. Ein Textgenerierungsmodell für eine Sprachlernsoftware muss grammatikalisch korrekte und semantisch plausible Texte generieren, der Wahrheitsgehalt ist jedoch irrelevant. Ein Frage-Antwort- oder Informationsabrufsystem hingegen muss genau und wahrheitsgetreu sein.

Die vielleicht portabelste Bewertungsstrategie für die Textgenerierung ist der von Hardcastle und Scott vorgeschlagene Turing-Test, der auf jeden Bereich angewendet werden kann. Leider kann dieser nicht automatisch ausgeführt werden, da menschliche Tester erforderlich sind und einige automatisierte Messgrößen erforderlich sind.

Bei meinen Sätzen für Sprachenlernende würde ich den Turing-Test mit einem Grammatikprüfungsmodell und möglicherweise einigen benutzerdefinierten Messwerten in Bezug auf Stimmungswert, Vorhandensein und Fehlen von Schimpfwörtern und kulturelle Relevanz kombinieren.

Um ein generatives Modell anhand einer eher sachbezogenen Aufgabe, wie etwa einer Rechtsberatung , zu validieren, würde ich einem Anwalt auf dem entsprechenden Gebiet (z. B. Konkurs- und Insolvenzrecht) erlauben, eine Blindbewertung der Antworten von GPT-3 durchzuführen, vielleicht in einem direkten Vergleich mit den Antworten eines menschlichen Experten – sowohl um die Wahrhaftigkeit zu bewerten als auch um zu versuchen, den Menschen zu identifizieren (der Turing-artige Test). Im Idealfall würde der Anwalt ein Bewertungsschema erstellen, das eine automatische Bewertung zukünftiger Iterationen des generativen Modells ermöglicht.

Aus meinen Experimenten geht hervor, dass GPT-3 für die Textgenerierung im Bereich des Sprachenlernens sehr geeignet scheint (vorausgesetzt, die betreffende Sprache ist gut ausgestattet und deckt eine gute Abdeckung ab), für die Rechtsberatung jedoch möglicherweise sehr irreführend ist!

Wenn Sie Interesse daran haben, ein generatives Modell zu erstellen oder zu evaluieren, zögern Sie bitte nicht, uns zu kontaktieren , damit wir einen Termin vereinbaren können. Wenn Sie Ihr eigenes LLM trainieren möchten, sehen Sie sich meine mehrsprachige Liste von NLP-Textkorpora auf unserer Schwesterseite naturallanguageprocessing.com an.

Hardcastle, David und Donia Scott. „ Können wir die Qualität des generierten Textes bewerten? “ LREC. 2008.

Celikyilmaz, Asli, Elizabeth Clark und Jianfeng Gao. „ Evaluation der Textgenerierung: Eine Umfrage. “ arXiv-Preprint arXiv:2006.14799 (2020).

Zhang, Tianyi, et al. „ Bertscore: Auswertung der Textgenerierung mit BERT. “ arXiv-Preprint arXiv:1904.09675 (2019).

Lin, Stephanie, Jacob Hilton und Owain Evans. „ TruthfulQA: Messen, wie Modelle menschliche Unwahrheiten nachahmen .“ arXiv-Vorabdruck arXiv:2109.07958 (2021). Blogbeitrag .

Wang, Xuezhi, et al. „ Selbstkonsistenz verbessert das Denken in Gedankenketten in Sprachmodellen .“ arXiv-Vorabdruck arXiv:2203.11171 (2022).

Bereit für den nächsten Schritt in Ihrer NLP-Reise? Vernetzen Sie sich mit Top-Arbeitgebern, die Talente in der natürlichen Sprachverarbeitung suchen. Entdecken Sie Ihren Traumjob!

Finden Sie Ihren Traumjob

Generative KI Einführung Generative KI , ein Teilbereich der KI, verändert Branchen grundlegend und gestaltet die Zukunft. Durch die Nutzung fortschrittlicher Algorithmen kann generative KI Inhalte, Designs und Lösungen erstellen, die zuvor undenkbar waren. Durch die Verwendung von Modellen des maschinellen Lernens wie Generative Adversarial Networks (GANs) und Variational Autoencoders (VAEs) können generative KI-Systeme neue Daten erstellen, die die Muster und Strukturen der Trainingsdaten nachahmen.

Große Daten Das Aufkommen von Big Data hat ganze Branchen revolutioniert und traditionelle Geschäftsmodelle und Entscheidungsprozesse verändert. In dieser umfassenden Untersuchung gehen wir der Frage nach, was Big Data ist, welche erheblichen Auswirkungen es auf die Geschäftsstrategie hat und wie Unternehmen riesige Datenmengen nutzen können, um Innovationen voranzutreiben und sich einen Wettbewerbsvorteil zu verschaffen.

KI im Finanzwesen Die Integration künstlicher Intelligenz (KI) in den Finanzsektor hat die Arbeitsweise von Institutionen revolutioniert, von der Automatisierung von Abläufen bis hin zur Verbesserung der Kundenbindung und des Risikomanagements. Diese umfassende Untersuchung wird mehrere Schlüsselbereiche untersuchen, in denen KI in der Branche erhebliche Fortschritte macht.

What we can do for you