Bereit für den nächsten Schritt in Ihrer NLP-Reise? Vernetzen Sie sich mit Top-Arbeitgebern, die Talente in der natürlichen Sprachverarbeitung suchen. Entdecken Sie Ihren Traumjob!

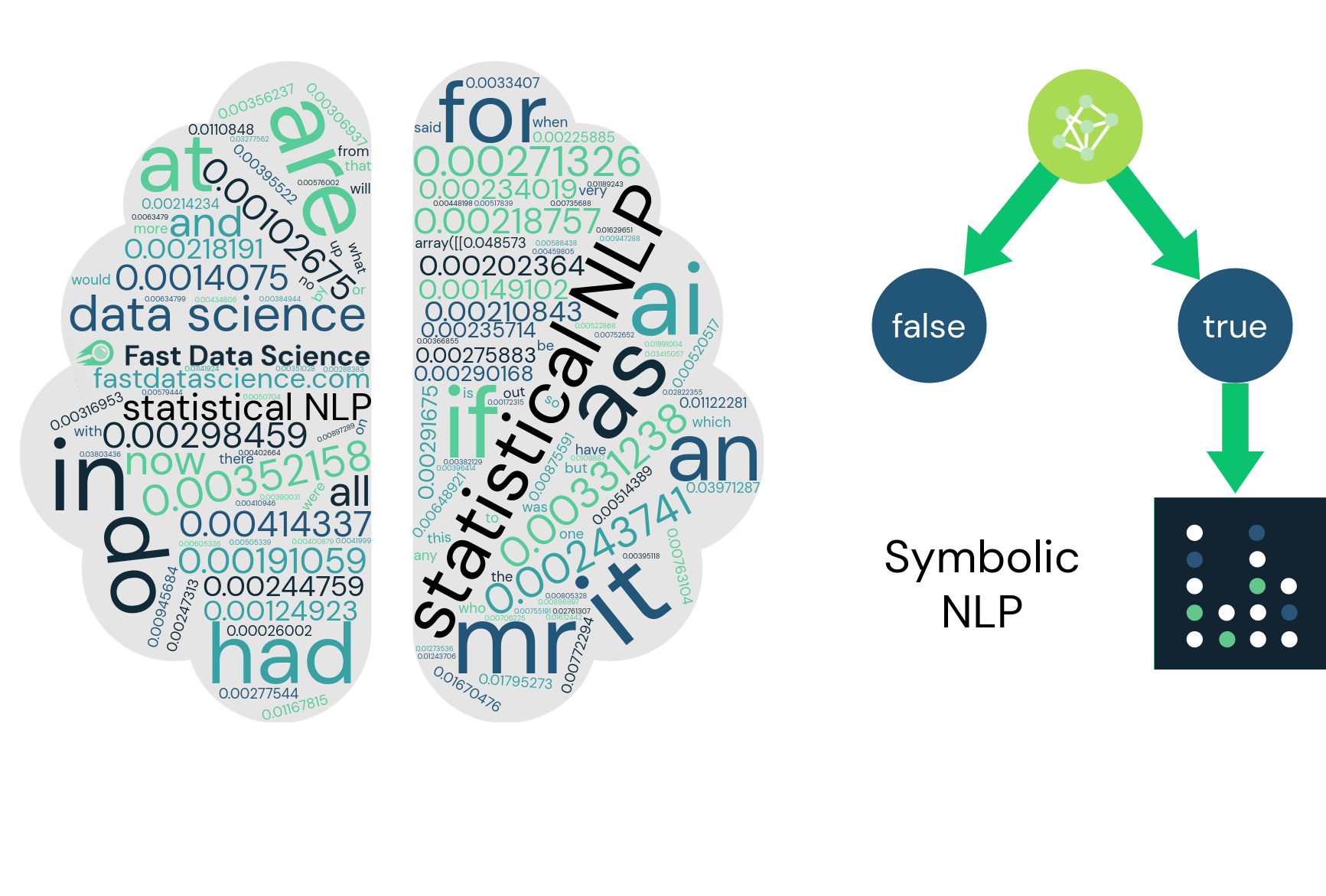

Finden Sie Ihren TraumjobMit dem Aufkommen künstlicher Intelligenz wird Automatisierung Teil des Alltags. Die Verarbeitung natürlicher Sprache (NLP) hat sich als Schlüsselelement dieses Durchbruchs erwiesen. Die Verarbeitung natürlicher Sprache schließt die Lücke zwischen Computern, KI und Computerlinguistik. Erfahren Sie mehr über NLP-Ansätze in diesem Leitfaden zum statistischen und symbolischen NLP.

Ein einfacher, von Menschen gesprochener Satz besteht aus verschiedenen Tönen, Wörtern, Bedeutungen und Werten. Experten-KI-Systeme sind in der Lage, diese verborgenen Strukturen und Bedeutungen zu nutzen, um menschliches Verhalten zu verstehen. Allerdings benötigen wir oft eine sehr genaue und detaillierte Beurteilung, um zu entscheiden, welche Bedeutung richtig sein könnte und welche nicht. Wenn wir eine große Menge an Textdaten haben, kann es unmöglich werden, sie schnell zu lesen.

Ein Beispiel für unstrukturierte Daten sind Rohtextdaten in Englisch oder anderen Sprachen. Diese Art von Daten passen nicht in eine relationale Datenbank und sind mit Computerprogrammen schwer zu interpretieren. Die Verarbeitung natürlicher Sprache ist ein Teilgebiet der KI, das sich damit beschäftigt, wie Computer menschliche Sprache interpretieren, verstehen und manipulieren.

Wie würden Sie einen NLP-Algorithmus trainieren, um mit langen dänischen zusammengesetzten Wörtern wie „Håndværkergården“ („der Handwerkerhof“) umzugehen? Würden Sie ein Wörterbuch aller möglichen Verbindungen erstellen oder versuchen, Wörter in ihre Bestandteile zu zerlegen?

NLP ist viel mehr als Sprach- und Textanalyse. Je nachdem, was zu tun ist, kann es unterschiedliche Vorgehensweisen geben. Es gibt drei Hauptansätze:

Statistischer Ansatz: Der statistische Ansatz zur Verarbeitung natürlicher Sprache basiert auf der Suche nach Mustern in großen Textmengen. Durch das Erkennen dieser Trends kann das System sein eigenes Verständnis der menschlichen Sprache entwickeln. Zu den modernsten Beispielen für statistisches NLP gehören Deep Learning und neuronale Netze.

Symbolischer Ansatz: Beim symbolischen Ansatz von NLP geht es mehr um von Menschen entwickelte Regeln. Ein Programmierer schreibt eine Reihe von Grammatikregeln, um zu definieren, wie sich das System verhalten soll.

Konnektionistischer Ansatz oder „ hybrider “ Ansatz: Der dritte Ansatz ist eine Kombination aus statistischen und symbolischen Ansätzen. Wir beginnen mit einem symbolischen Ansatz und verstärken ihn mit statistischen Regeln.

Sehen wir uns nun an, wie diese NLP-Ansätze von Maschinen zur Interpretation von Sprache verwendet werden.

Das Dolmetschen von Sprachen kann in mehrere Ebenen unterteilt werden. Jede Ebene ermöglicht es der Maschine, Informationen auf einer höheren Komplexitätsebene zu extrahieren.

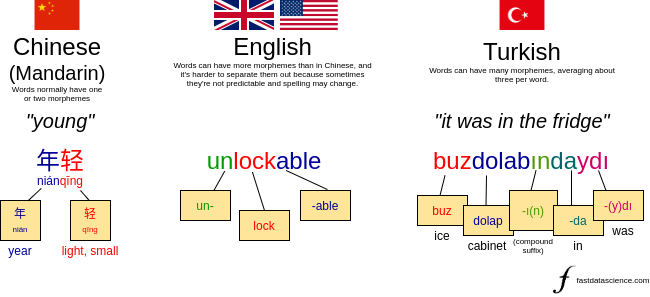

Morphologische Ebene : Innerhalb eines Wortes ist eine Struktur namens Morphem die kleinste Bedeutungseinheit. Das Wort „unlockable“ besteht aus drei Morphemen: un+lock+able. Ebenso besteht „glücklich“ aus zwei Wörtern: glücklich+ly. Bei der morphologischen Analyse geht es darum, die Morpheme innerhalb eines Wortes zu identifizieren, um die Bedeutung zu ermitteln.

Ein chinesisches Wort, ein englisches Wort und ein türkisches Wort. Einige Sprachen, wie zum Beispiel Mandarin, haben ein oder zwei Morpheme pro Wort, und andere, wie zum Beispiel Türkisch, können viele Morpheme pro Wort haben. Englisch liegt irgendwo in der Mitte. Das gezeigte Beispiel von „unlockable“ kann entweder als un+lockable oder unlock+able analysiert werden, was die inhärente Mehrdeutigkeit vieler der von uns im NLP durchgeführten Analysen veranschaulicht.

In der Praxis müssten wir im englischen NLP, abgesehen vom Entfernen von Suffixen wie „ing“ aus Wörtern, normalerweise nicht auf die morphologische Ebene eingehen. Bei stark flektierten Sprachen wie Shona kann der Umgang mit Unterwortmorphemen unvermeidlich sein. Ich bin in meinem Beitrag auf [https://fastdatascience.com/data-science-26-important/-natural-Language-Processing/] näher darauf eingegangen.

Lexikalische Ebene: Die nächste Ebene der Analyse besteht darin, Wörter als Ganzes zu betrachten.

Ein Beispiel für einen vollständig lexikalischen NLP-Ansatz ist ein Naive-Bayes-Klassifikator , der Texte basierend auf der Worthäufigkeit und ohne Berücksichtigung der Satzstruktur als Sport oder Politik, Spam oder Ham kategorisieren kann.

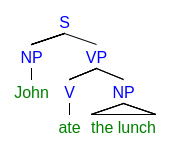

Syntaktische Ebene : Die syntaktische Analyse geht einen Schritt weiter und konzentriert sich auf die Struktur eines Satzes: wie Wörter miteinander interagieren.

Ein Analysebaum ist eine Möglichkeit, die Syntax eines Satzes darzustellen.

Ein NLP-System, das auf der syntaktischen Ebene arbeitet, könnte den Unterschied zwischen „Dieser Film war sehenswert“ und „Der Film ist sicherlich nicht sehenswert“ erkennen. Diese Nuancen sind mit einer Wortschatztechnik wie dem Naive Bayes Classifier schwer zu erfassen.

Semantische Ebene: Die semantische Analyse beschäftigt sich damit, wie wir die Satzstruktur in eine Bedeutungsinterpretation umwandeln können.

Ein semantischer NLP-Ansatz könnte möglicherweise zu Erkenntnissen führen wie „40 % der Ärzte glaubten, dass es eine Wechselwirkung zwischen Medikament A und Medikament B gibt.“

Diskursebene: Hier geht es um die Verbindung zwischen zwei Sätzen. Das ist unglaublich knifflig: Wenn jemand „er“ sagt, woher wissen wir dann aus einem früheren Satz, wen er meint, wenn mehrere Personen erwähnt wurden?

(Im Jahr 2008 habe ich meine Masterarbeit über das Wort „es“ geschrieben und mich dabei darauf konzentriert, wie wir das pleonastische „es“ wie „es regnet“ von dem „es“ unterscheiden können, das sich auf etwas in einem vorherigen Satz bezieht. Im Zeitalter von GPT, das Problem bleibt ungelöst!)

Nachdem wir nun ein klares Verständnis der Verarbeitung natürlicher Sprache haben, sind hier einige gängige Beispiele für NLP:

Außer Kontrolle geratene soziale Medien können einer Marke schaden.

Eines der besten Beispiele für die Verarbeitung natürlicher Sprache ist die Überwachung sozialer Medien. Negative Publicity ist nicht gut für eine Marke und eine gute Möglichkeit herauszufinden, was Ihre Kunden denken, ist es, die sozialen Medien im Auge zu behalten.

Plattformen wie Buffer und Hootsuite nutzen NLP-Technologie, um Kommentare und Beiträge zu einer Marke zu verfolgen. Mithilfe von NLP können Unternehmen benachrichtigt werden, wenn ein negativer Tweet oder eine negative Erwähnung veröffentlicht wird, sodass sie ein Problem mit dem Kundenservice beheben können, bevor es zu einer Katastrophe wird.

Während es beim Standard-Social-Media-Monitoring um geschriebene Texte geht, können wir mit Sentiment-Analyse-Techniken einen tieferen Blick auf die Emotionen des Nutzers werfen.

Die Wortwahl des Nutzers gibt einen Hinweis darauf, wie sich der Nutzer beim Verfassen des Beitrags gefühlt hat. Wenn sie beispielsweise Wörter wie „glücklich “, „gut “ und „loben “ verwenden, deutet dies auf ein positives Gefühl hin. Allerdings ist die Sentimentanalyse alles andere als einfach: Sie kann durch Sarkasmus, Doppeldeutigkeiten und komplexe Satzstrukturen gestört werden, daher sollte ein guter Algorithmus zur Sentimentanalyse die Satzstruktur berücksichtigen.

Unternehmen nutzen Sentimentanalysen häufig, um die Reaktionen der Kunden auf ihre Marken zu beobachten, wenn etwas Neues eingeführt wird.

Einfache Texte können tiefe Bedeutungen haben und auf mehrere Unterkategorien verweisen. Erwähnungen von Orten, Daten, Standorten, Personen und Unternehmen können wertvolle Daten liefern. Die leistungsstärksten Modelle sind häufig sehr branchenspezifisch und werden von Unternehmen entwickelt, die über große Datenmengen in ihrem Bereich verfügen. Ein maschinelles Lernmodell kann trainiert werden, um das Gehalt eines Jobs anhand seiner Beschreibung oder das Risikoniveau eines Hauses oder eines Seeschiffs anhand eines Sicherheitsinspektionsberichts vorherzusagen.

Eine coole Anwendung ist die forensische Stilometrie , bei der es darum geht, den Autor eines Dokuments anhand des Schreibstils zu bestimmen. Ich habe ein einfaches forensisches Stilometriemodell mit einer Online-Demo trainiert, um herauszufinden, welcher der drei berühmten Autoren wahrscheinlich einen Text geschrieben hat.

Forensische Stilometrie ist eine NLP-Technik, die es uns ermöglicht, in die Rolle eines Detektivs zu schlüpfen und den Autor eines von Ghostwritern verfassten Romans, eines anonymen Briefes oder einer Lösegeldforderung zu identifizieren. Das Bild von Sherlock Holmes ist gemeinfrei.

Die Verarbeitung natürlicher Sprache hat auch bei der Krankheitsdiagnose und der Pflege geholfen und die Gesamtkosten der Gesundheitsversorgung gesenkt. NLP kann Ärzten dabei helfen, elektronische Gesundheitsakten zu analysieren und anhand der großen Menge an Textdaten, die die Krankengeschichte einer Person detailliert beschreiben, sogar das Fortschreiten einer Krankheit vorherzusagen.

Um nur ein kommerzielles Angebot zu nennen: Amazon Comprehend Medical nutzt NLP, um Daten über Krankheitszustände, Medikamente und Ergebnisse klinischer Studien zu sammeln. Solche Unternehmungen können bei der Früherkennung von Krankheiten helfen. Derzeit wird es bei verschiedenen Gesundheitszuständen eingesetzt, darunter Herz-Kreislauf-Erkrankungen, Schizophrenie und Angstzustände.

IBM hat kürzlich einen kognitiven Assistenten entwickelt, der wie eine persönliche Suchmaschine funktioniert. Es kennt detaillierte Informationen über eine Person und stellt diese Informationen dann bei entsprechender Aufforderung dem Benutzer zur Verfügung. Dies ist ein positiver Schritt, um Menschen mit Gedächtnisproblemen zu helfen.

Wir haben einige Beispiele für praktische Anwendungen der Verarbeitung natürlicher Sprache gesehen. Hier geben wir einen kurzen Einblick in die wichtigsten NLP-Techniken und die zugrunde liegenden Phasen einer NLP-Pipeline.

Das Bag-of-Words-Modell ist das einfachste Modell im NLP. Wenn wir eine Wortanalyse durchführen, ignorieren wir die Reihenfolge, Grammatik und Semantik der Wörter. Wir zählen einfach alle Wörter in einem Dokument und geben diese Zahlen in einen maschinellen Lernalgorithmus ein.

Wenn wir beispielsweise ein Modell erstellen, um Nachrichtenartikel entweder in Sport oder Finanzen zu klassifizieren, können wir den Bag-of-Words-Score für zwei Artikel wie folgt berechnen:

| Word | Article A | Article B |

| interest | 3 | 1 |

| goal | 1 | 2 |

| football | 0 | 2 |

| bank | 2 | 0 |

Beispiel einer Wortschatzbewertung für zwei Artikel, die wir dem Sport oder dem Finanzwesen zuordnen möchten.

Anhand des obigen Beispiels sollte es leicht zu erkennen sein, welcher Artikel zu welcher Kategorie gehört.

Der Hauptnachteil der Bag-of-Words-Methode besteht darin, dass wir viele nützliche Informationen, die in der Wortreihenfolge enthalten sind, wegwerfen. Aus diesem Grund wird Bag of Words in der Praxis in Produktionssystemen nicht häufig verwendet.

Die Tokenisierung ist oft die erste Stufe eines NLP-Modells. Um die Handhabung zu erleichtern, wird ein Dokument in Teile zerlegt. Oft ist jedes Wort ein Token, aber das ist nicht immer der Fall, und bei der Tokenisierung müssen Telefonnummern, E-Mail-Adressen und dergleichen nicht getrennt werden.

Nachfolgend finden Sie beispielsweise die Token für den Beispielsatz „Wann werden Sie nach England aufbrechen?“

| When | will | you | leave | for | England | ? |

Dieses Tokenisierungsbeispiel scheint einfach zu sein, da der Satz in Leerzeichen aufgeteilt werden könnte. Allerdings verwenden nicht alle Sprachen die gleichen Regeln zum Teilen von Wörtern. Für viele ostasiatische Sprachen wie Chinesisch ist die Tokenisierung sehr schwierig, da zwischen Wörtern keine Leerzeichen verwendet werden und es schwierig ist, herauszufinden, wo ein Wort endet und das nächste Wort beginnt. Aufgrund der zusammengesetzten Wörter, die je nach ihrer Funktion in einem Satz einzeln oder zusammen geschrieben werden können, kann es auch schwierig sein, Deutsch zu tokenisieren.

Auch für einige Wörter wie „New York“ ist die Tokenisierung nicht wirksam. Sowohl New als auch York können unterschiedliche Bedeutungen haben, daher kann die Verwendung eines Tokens verwirrend sein. Aus diesem Grund folgt auf die Tokenisierung häufig eine Phase namens Chunking , in der wir Ausdrücke mit mehreren Wörtern, die von einem Tokenisierer aufgeteilt wurden, wieder zusammenfügen.

Die Tokenisierung kann für den Umgang mit Textdomänen, die Klammern, Bindestriche und andere Satzzeichen enthalten, ungeeignet sein. Durch das Entfernen dieser Details werden die Bedingungen durcheinander gebracht. Um diese Probleme zu lösen, werden die folgenden unten aufgeführten Methoden in Kombination mit der Tokenisierung verwendet.

Nach der Tokenisierung ist es üblich, Stoppwörter zu verwerfen, bei denen es sich um Pronomen, Präpositionen und gebräuchliche Artikel wie „to“ und „the“ handelt. Dies liegt daran, dass sie oft keine für unsere Zwecke nützlichen Informationen enthalten und problemlos entfernt werden können. Stoppwortlisten sollten jedoch sorgfältig ausgewählt werden, da eine Liste, die für einen Zweck oder eine Branche funktioniert, für einen anderen möglicherweise nicht geeignet ist.

Um sicherzustellen, dass dabei keine wichtigen Informationen ausgeschlossen werden, erstellt normalerweise ein menschlicher Bediener die Liste der Stoppwörter.

Beim Stemming werden die Affixe entfernt. Dazu gehören sowohl Präfixe als auch Suffixe der Wörter.

Suffixe stehen am Ende des Wortes. Beispiele für Suffixe sind „-able“, „-acy“, „-en“, „-ful“. Wörter wie „wunderbar“ werden in „wunderbar“ umgewandelt.

Präfixe stehen vor einem Wort. Einige der häufigsten Beispiele für Präfixe sind „hyper-“, „anti-“, „dis-“, „tri-“, „re-“ und „uni-“.

Um die Wortstammerkennung durchzuführen, wird eine gemeinsame Liste von Affixen erstellt und diese programmgesteuert aus den Wörtern in der Eingabe entfernt. Der Wortstamm sollte mit Vorsicht verwendet werden, da er die Bedeutung des eigentlichen Wortes verändern kann. Stemmer sind jedoch einfach zu verwenden und können sehr schnell bearbeitet werden. Ein im Englischen und anderen Sprachen gebräuchlicher Stemmer ist der Porter Stemmer .

Die Lemmatisierung hat ein ähnliches Ziel wie die Wortstammbildung: Die verschiedenen Formen eines Wortes werden in eine einzige Grundform umgewandelt. Der Unterschied besteht darin, dass die Lemmatisierung auf einer Wörterbuchliste beruht. Daher werden „ate“, „eating“ und „eaten“ auf der Grundlage des Wörterbuchs alle auf „eat“ abgebildet, während ein Stemming-Algorithmus dieses Beispiel nicht verarbeiten könnte.

Lemmatisierungsalgorithmen müssen im Idealfall den Kontext eines Wortes in einem Satz kennen, da die richtige Grundform beispielsweise davon abhängen kann, ob das Wort als Substantiv oder Verb verwendet wurde. Darüber hinaus kann eine Begriffsklärung erforderlich sein, um identische Wörter mit unterschiedlichen Grundformen zu unterscheiden.

Need a new NLP approach?

Viele Jahrzehnte lang versuchten Forscher, Texte in natürlicher Sprache zu verarbeiten, indem sie immer kompliziertere Regeln aufstellten. Das Problem des regelbasierten Ansatzes besteht darin, dass die Grammatik des Englischen und anderer Sprachen eigenwillig ist und keinem festen Regelwerk entspricht.

Als ich an unserem Clinical Trial Risk Tool arbeitete, musste ich eine Reihe von Schlüsselwerten aus technischen Dokumenten identifizieren. Ein Wert, den ich brauchte, war die Anzahl der Teilnehmer an einem Versuch. Ich habe versucht, eine Reihe von Regeln zu schreiben, um die Anzahl der Teilnehmer aus einem klinischen Studienprotokoll (dem PDF-Dokument, das beschreibt, wie eine Studie durchgeführt werden soll) zu extrahieren. Ich habe Sätze wie die folgenden gefunden:

Wir haben 450 Teilnehmer rekrutiert

Die Teilnehmerzahl betrug N= 231

Die ursprüngliche Absicht bestand darin, 45 Probanden zu rekrutieren, aufgrund von Studienabbrechern lag die endgültige Zahl jedoch bei 38

Sie sehen, wie schwierig es wäre, einen robusten Satz an Anweisungen zu schreiben, damit ein Computer zuverlässig die richtige Zahl identifizieren kann.

Daher ist es bei solchen Problemen oft sinnvoller, die schwere Arbeit dem Computer zu überlassen. Wenn Sie über mehrere tausend Dokumente verfügen und die tatsächliche Anzahl der Teilnehmer an jedem dieser Dokumente kennen (vielleicht sind die Informationen in einer externen Datenbank verfügbar), kann ein neuronales Netzwerk lernen, die Muster selbst zu finden und die Anzahl der Themen zu erkennen in einem neuen, unsichtbaren Dokument.

Ich glaube, dass dies der Weg in die Zukunft ist und dass einige der traditionellen NLP-Techniken immer seltener eingesetzt werden, da Rechenleistung allgemeiner verfügbar wird und die Wissenschaft Fortschritte macht.

Zu den gängigen neuronalen Netzen, die für NLP verwendet werden, gehören LSTM , Convolutional Neural Networks und Transformers .

Der Bereich der Verarbeitung natürlicher Sprache hat sich in den letzten Jahrzehnten weiterentwickelt und einige sinnvolle Wege zu einer fortschrittlicheren und besseren Welt eröffnet. Während die Dekodierung verschiedener Sprachen und Dialekte auf der ganzen Welt immer noch Herausforderungen mit sich bringt, verbessert sich die Technologie weiterhin rasant.

NLP hat bereits Anwendungen bei der Suche nach Gesundheitslösungen und bei der Unterstützung von Unternehmen bei der Erfüllung der Erwartungen ihrer Kunden gefunden. Wir können davon ausgehen, dass die Verarbeitung natürlicher Sprache unser Leben in Zukunft auf viele weitere unerwartete Arten beeinflussen wird.

Bereit für den nächsten Schritt in Ihrer NLP-Reise? Vernetzen Sie sich mit Top-Arbeitgebern, die Talente in der natürlichen Sprachverarbeitung suchen. Entdecken Sie Ihren Traumjob!

Finden Sie Ihren Traumjob

Mittlerweile sind es Organisationen aller Größenordnungen und fast aller Sektoren werden zunehmend datengesteuert, insbesondere als größere Datenspeicher Systeme und schnellere Computer treiben die Leistungsgrenzen immer weiter voran.

Aufgrund des umfangreichen Einsatzes von Technologie und der Arbeitsteilung hat die Arbeit des durchschnittlichen Gig-Economy-Arbeiters jeden individuellen Charakter und damit auch jeden Charme für den Arbeitnehmer verloren.

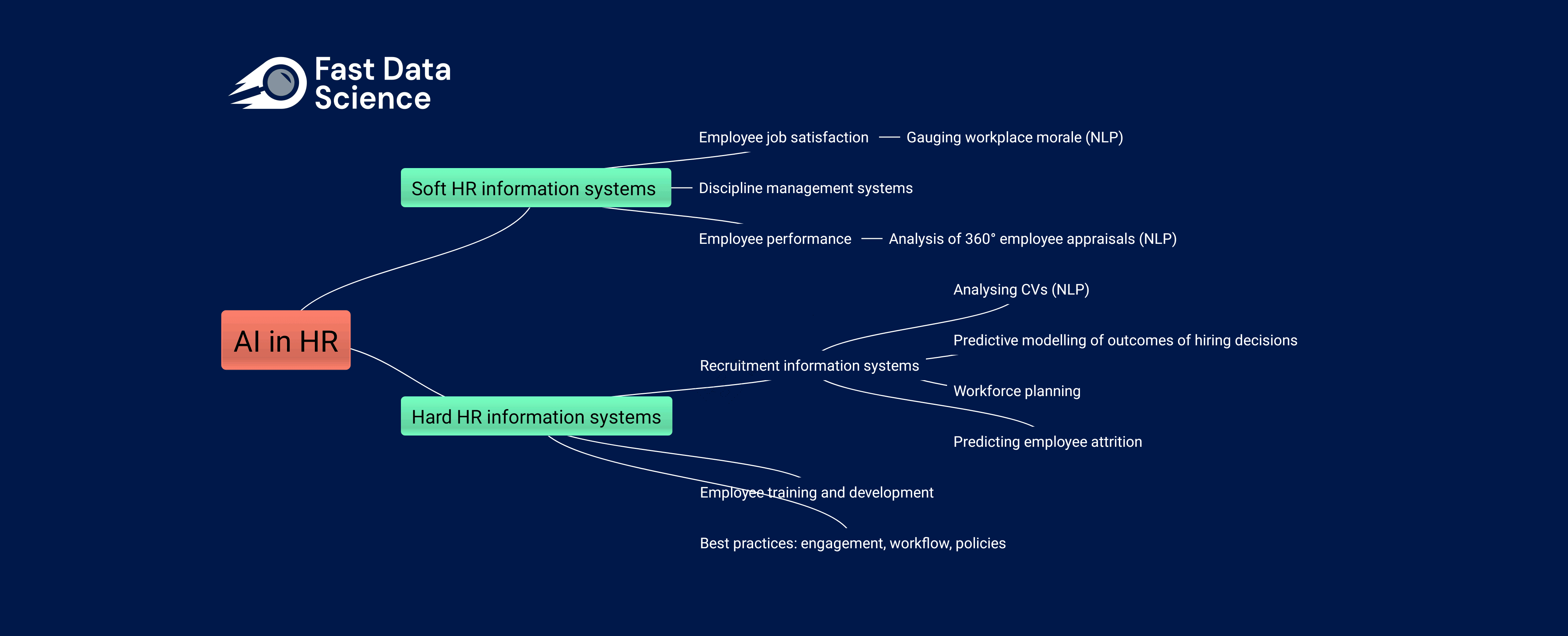

Die Auswirkungen von KI auf die Humanressourcen Die Arbeitswelt verändert sich rasant, sowohl aufgrund der Einführung traditioneller Data-Science-Praktiken in immer mehr Unternehmen als auch aufgrund der zunehmenden Beliebtheit generativer KI-Tools wie ChatGPT und Googles BARD bei nicht-technischen Arbeitnehmern.

What we can do for you