In den letzten Wochen berichteten mehrere Apple Card-Nutzer in den USA, dass ihnen und ihren Partnern auf der Markenkreditkarte völlig unterschiedliche Kreditlimits zugewiesen worden seien, obwohl sie über dasselbe Einkommen und dieselbe Kreditwürdigkeit verfügten (siehe BBC-Artikel ). Steve Wozniak, Mitbegründer von Apple, twitterte, dass sein Kreditlimit auf der Karte zehnmal höher sei als das seiner Frau, obwohl das Paar auf allen seinen anderen Karten über dieselben Kreditlimits verfüge.

Das Department of Financial Services in New York, eine Aufsichtsbehörde für Finanzdienstleistungen, untersucht Vorwürfe, dass das Geschlecht der Nutzer der Grund für die Ungleichheit sein könnte. Apple weist ausdrücklich darauf hin, dass Goldman Sachs für den Algorithmus verantwortlich sei, was offenbar im Widerspruch zu Apples Marketingslogan „Erstellt von Apple, nicht von einer Bank“ steht.

Da die Untersuchung der Aufsichtsbehörde noch im Gange ist und bisher keine Befangenheit nachgewiesen werden konnte, gehe ich in diesem Artikel ausschließlich hypothetisch vor.

Die Geschichte um die Apple Card ist nicht das einzige Beispiel für algorithmische Voreingenommenheit, das in jüngster Zeit Schlagzeilen macht. Im Juli letzten Jahres unterzeichnete die NAACP (National Association for the Advancement of Colored People) in den USA eine Erklärung, in der sie ein Moratorium für den Einsatz automatisierter Entscheidungsfindungstools forderte, da sich gezeigt hat, dass einige von ihnen bei der Vorhersage von Rückfällen – also der Wahrscheinlichkeit, mit der ein Täter erneut straffällig wird – rassistische Voreingenommenheit aufweisen.

2013 wurde Eric Loomis zu sechs Jahren Gefängnis verurteilt, nachdem der Bundesstaat Wisconsin ein Programm namens COMPAS verwendet hatte, um seine Wahrscheinlichkeit zu berechnen, ein weiteres Verbrechen zu begehen. COMPAS ist ein proprietärer Algorithmus, dessen Funktionsweise nur der Hersteller Equivant kennt. Loomis versuchte, die Verwendung des Algorithmus vor dem Obersten Gerichtshof von Wisconsin anzufechten, doch seine Klage wurde letztlich abgelehnt.

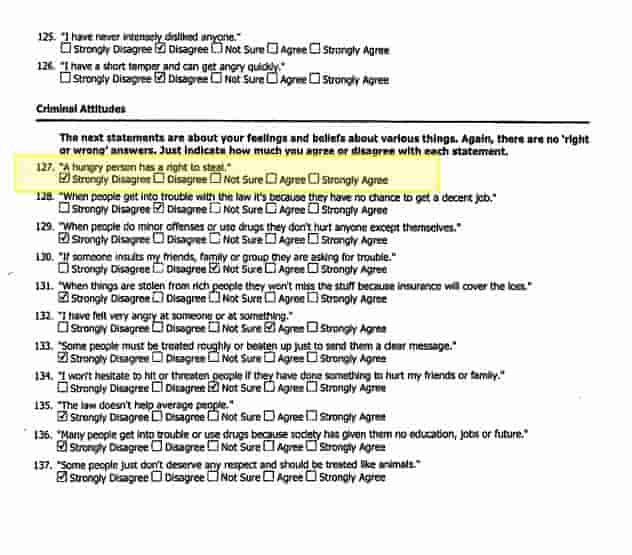

Ein Screenshot des Fragebogens, den ein Verdächtiger ausfüllt und den das COMPAS-Modell zur Vorhersage des Rückfallrisikos verwendet. Dem COMPAS-Modell wurde eine KI-Voreingenommenheit vorgeworfen. Bildquelle und vollständiges Dokument .

Leider verstärken derartige Vorfälle nur die weitverbreitete Wahrnehmung der KI als eines gefährlichen, undurchsichtigen und unzureichend regulierten Werkzeugs, das die schlimmsten Vorurteile der Gesellschaft verkörpern kann.

Ich werde mich hier auf das Beispiel eines Kreditantrags konzentrieren, da dieses Problem einfacher zu formulieren und zu analysieren ist. Die von mir angesprochenen Punkte sind jedoch auf jede Art von Voreingenommenheit und geschützte Kategorie übertragbar.

Ich möchte zunächst darauf hinweisen, dass ich stark bezweifle, dass sich irgendjemand bei Apple oder Goldman Sachs zusammengesetzt und einen expliziten Regelsatz erstellt hat, der das Geschlecht bei Kreditentscheidungen berücksichtigt.

Stellen wir uns zunächst einmal vor, wir erstellen ein maschinelles Lernmodell , das die Wahrscheinlichkeit vorhersagt, dass eine Person einen Kredit nicht zurückzahlt. Es gibt eine Reihe „geschützter Kategorien“, wie z. B. das Geschlecht, bei denen wir nicht diskriminieren dürfen.

Die Entwicklung und Schulung einer KI zur Kreditentscheidung ist eine Art „einfaches“ Data-Science-Problem, das regelmäßig auf Kaggle (einer Website, auf der Sie an Data-Science-Wettbewerben teilnehmen können) auftaucht und zu dem angehende Data Scientists in Vorstellungsgesprächen befragt werden. Das Rezept für einen Roboter- Kreditsachbearbeiter lautet wie folgt:

Stellen Sie sich vor, Sie verfügen über eine große Tabelle mit 10.000 Zeilen, die sich ausschließlich auf Kreditantragsteller beziehen, die Ihre Bank in der Vergangenheit gesehen hat:

| Alter | Einkommen | Kreditwürdigkeit | Geschlecht | Bildungsniveau | Anzahl der Jahre beim Arbeitgeber | Berufsbezeichnung | sind sie in Verzug geraten? |

|---|---|---|---|---|---|---|---|

| 38 | 28000 | 460 | M | Bachelor | 2 | Krankenschwester | NEIN |

Fast Data Science - London

Die letzte Spalte enthält die Daten, die wir vorhersagen möchten.

Sie würden diese Daten nehmen und die Zeilen in drei Gruppen aufteilen, den sogenannten Trainingssatz, den Validierungssatz und den Testsatz.

Sie wählen dann einen Algorithmus für maschinelles Lernen aus, z. B. Lineare Regression , Random Forest oder Neuronale Netzwerke , und lassen ihn aus den Trainingszeilen „lernen“, ohne ihm die Validierungszeilen zu zeigen. Anschließend testen Sie ihn mit dem Validierungssatz. Sie wiederholen dies für verschiedene Algorithmen , wobei Sie die Algorithmen jedes Mal optimieren. Das Modell, das Sie schließlich einsetzen, ist dasjenige, das in Ihren Validierungszeilen am besten abgeschnitten hat.

Wenn Sie fertig sind, dürfen Sie Ihr Modell am Testdatensatz testen und seine Leistung überprüfen.

Wenn die Spalte „Geschlecht“ in den Trainingsdaten vorhanden ist, besteht offensichtlich das Risiko, dass ein verzerrtes Modell erstellt wird.

Allerdings haben die Datenwissenschaftler von Apple/Goldman diese Spalte wahrscheinlich von Anfang an aus ihrem Datensatz entfernt.

Wie kann es also sein, dass der digitale Geldverleiher immer noch geschlechtsspezifisch ist? Unser Algorithmus kann doch unmöglich sexistisch sein, oder? Schließlich kennt er nicht einmal das Geschlecht des Antragstellers!

Leider und kontraintuitiv ist es immer noch möglich, dass sich Voreingenommenheit einschleicht!

Unser Datensatz könnte Informationen enthalten, die ein Indikator für das Geschlecht sind. Beispielsweise könnten die Dauer der aktuellen Beschäftigung, das Gehalt und insbesondere die Berufsbezeichnung alle mit der Frage korrelieren, ob unser Bewerber männlich oder weiblich ist.

Wenn es möglich ist, ein maschinelles Lernmodell anhand Ihres bereinigten Datensatzes zu trainieren, um das Geschlecht mit einem gewissen Grad an Genauigkeit vorherzusagen, besteht das Risiko, dass Ihr Modell versehentlich geschlechtsspezifisch ist. Ihr Kreditvorhersagemodell könnte lernen, die impliziten Hinweise zum Geschlecht im Datensatz zu verwenden, auch wenn es das Geschlecht selbst nicht sehen kann.

Ich möchte eine Ergänzung zum Arbeitsablauf der KI-Entwicklung vorschlagen: Wir sollten unsere KI aus verschiedenen Blickwinkeln angehen und versuchen, mögliche Voreingenommenheiten zu entdecken, bevor wir sie einsetzen.

Es genügt nicht, einfach die geschützten Kategorien aus Ihrem Datensatz zu entfernen, sich die Hände abzuklopfen und zu denken: „Aufgabe erledigt.“

Wir müssen bei der Entwicklung einer KI auch den Advocatus Diaboli spielen und statt nur zu versuchen, die Ursachen für eine Voreingenommenheit zu beseitigen, sollten wir versuchen , das Vorhandensein einer Voreingenommenheit nachzuweisen .

Wenn Sie sich mit der Cybersicherheit auskennen, haben Sie sicher schon einmal vom Konzept eines Pentests oder Penetrationstests gehört. Eine Person, die nicht an der Entwicklung Ihres Systems beteiligt war, beispielsweise ein externer Berater , versucht, Ihr System zu hacken, um Schwachstellen zu entdecken.

Ich schlage vor, dass wir KI-Pen-Tests einführen sollten: eine Analogie zum Pen-Test zur Aufdeckung und Beseitigung von KI-Voreingenommenheit :

Um eine KI auf Voreingenommenheit zu testen, würde entweder eine externe Person oder ein interner Datenwissenschaftler, der nicht an der Entwicklung des Algorithmus beteiligt war, versuchen, ein Vorhersagemodell zu erstellen, um die entfernten geschützten Kategorien zu rekonstruieren.

Kommen wir also zum Kreditbeispiel zurück: Wenn Sie das Geschlecht aus Ihrem Datensatz entfernt haben, würde der Penetrationstester sein Bestes geben, um ein Vorhersagemodell zu erstellen, um es wiederherzustellen. Vielleicht sollten Sie ihm einen Bonus zahlen, wenn er das Geschlecht einigermaßen genau rekonstruieren kann, und zwar in Höhe des Geldes, das Sie sonst für die Schadensbegrenzung ausgegeben hätten, wenn Sie unabsichtlich ein sexistisches Kreditvorhersagemodell geliefert hätten.

Zusätzlich zum oben genannten Penetrationstest empfehle ich die folgenden weiteren Überprüfungen:

Segmentieren Sie die Daten nach Geschlechtern. Bewerten Sie die Genauigkeit des Modells für jedes Geschlecht.

Identifizieren Sie etwaige Tendenzen zur Über- bzw. Unterschätzung der Ausfallwahrscheinlichkeit bei beiden Geschlechtern.

Identifizieren Sie etwaige Unterschiede in der Modellgenauigkeit nach Geschlecht.

Ich habe einige der offensichtlicheren Ursachen für KI-Voreingenommenheit nicht behandelt. Beispielsweise ist es möglich, dass die Trainingsdaten selbst voreingenommen sind. Dies ist bei einigen der im Strafrechtssystem verwendeten Algorithmen sehr wahrscheinlich.

Nehmen wir an, Sie haben festgestellt, dass der von Ihnen trainierte Algorithmus tatsächlich eine Voreingenommenheit gegenüber einer geschützten Kategorie wie dem Geschlecht aufweist. Sie haben folgende Möglichkeiten, dies zu mildern:

Eine Anwendung dieses Ansatzes, die ich gerne näher untersuchen würde, ist die Beseitigung von Voreingenommenheit, wenn Sie maschinelles Lernen für die Personalbeschaffung verwenden. Stellen Sie sich vor, Sie haben einen Algorithmus, der Lebensläufe mit Jobs abgleicht. Wenn er versehentlich Lücken in den Lebensläufen der Leute entdeckt, die mit Mutterschaftsurlaub und damit mit dem Geschlecht zusammenhängen, laufen wir Gefahr, dass es sich um eine diskriminierende KI handelt. Ich stelle mir vor, dass dies durch einige der oben genannten Vorschläge kompensiert werden könnte, beispielsweise durch die Optimierung der Trainingsdaten und die künstliche Entfernung dieser Art von Signalen. Ich denke, dass der Penetrationstest ein wirksames Instrument für diese Herausforderung wäre.

Große Unternehmen sind sich heute des Potenzials bewusst, das schlechte PR für virale Verbreitung haben kann. Wenn der Apple Card-Algorithmus also tatsächlich voreingenommen ist, wundert es mich, dass niemand den Algorithmus vor der Veröffentlichung gründlicher geprüft hat.

Ein je nach Geschlecht um den Faktor 10 unterschiedlicher Kreditrahmen ist ein eklatanter Fehler.

Hätten die am Kreditalgorithmus oder auch am vom US-Bundesstaat Wisconsin verwendeten Algorithmus zur Rückfallvorhersage beteiligten Datenwissenschaftler meine oben stehende Checkliste zum Penetrations- und Stresstest ihrer Algorithmen befolgt, hätten sie das PR-Desaster meiner Ansicht nach bemerkt, bevor es Schlagzeilen machen konnte.

Natürlich ist es einfach, im Nachhinein mit dem Finger auf die Täter zu zeigen, und der Bereich der Datenwissenschaft in der Großindustrie steckt noch in den Kinderschuhen. Manche würden es einen Wilden Westen der Unterregulierung nennen.

Ich denke, wir können auch froh darüber sein, dass einige konservative Branchen wie das Gesundheitswesen KI noch nicht für wichtige Entscheidungen eingesetzt haben. Man stelle sich die Folgen vor, wenn sich herausstellen würde, dass ein Algorithmus zur Melanomanalyse oder ein Entscheidungsmodell für Amniozentese rassistisch voreingenommen ist.

Aus diesem Grund würde ich großen Unternehmen, die Algorithmen zur Entscheidungsfindung auf den Markt bringen, dringend empfehlen, zunächst ein Team aus Datenwissenschaftlern abzustellen, deren Aufgabe nicht die Entwicklung von Algorithmen, sondern die Durchführung von Penetrations- und Stresstests mit ihnen ist.

Die Datenwissenschaftler, die die Modelle entwickeln, stehen unter zu großem Zeitdruck, um dies selbst tun zu können. Und wie die Cybersicherheitsbranche durch jahrelange Erfahrung herausgefunden hat, ist es manchmal besser, eine externe Person den Advocatus Diaboli spielen zu lassen und zu versuchen, Ihr System zum Einsturz zu bringen.

Entfesseln Sie das Potenzial Ihrer NLP-Projekte mit dem richtigen Talent. Veröffentlichen Sie Ihre Stelle bei uns und ziehen Sie Kandidaten an, die genauso leidenschaftlich über natürliche Sprachverarbeitung sind.

NLP-Experten einstellen

Generative KI Einführung Generative KI , ein Teilbereich der KI, verändert Branchen grundlegend und gestaltet die Zukunft. Durch die Nutzung fortschrittlicher Algorithmen kann generative KI Inhalte, Designs und Lösungen erstellen, die zuvor undenkbar waren. Durch die Verwendung von Modellen des maschinellen Lernens wie Generative Adversarial Networks (GANs) und Variational Autoencoders (VAEs) können generative KI-Systeme neue Daten erstellen, die die Muster und Strukturen der Trainingsdaten nachahmen.

Große Daten Das Aufkommen von Big Data hat ganze Branchen revolutioniert und traditionelle Geschäftsmodelle und Entscheidungsprozesse verändert. In dieser umfassenden Untersuchung gehen wir der Frage nach, was Big Data ist, welche erheblichen Auswirkungen es auf die Geschäftsstrategie hat und wie Unternehmen riesige Datenmengen nutzen können, um Innovationen voranzutreiben und sich einen Wettbewerbsvorteil zu verschaffen.

KI im Finanzwesen Die Integration künstlicher Intelligenz (KI) in den Finanzsektor hat die Arbeitsweise von Institutionen revolutioniert, von der Automatisierung von Abläufen bis hin zur Verbesserung der Kundenbindung und des Risikomanagements. Diese umfassende Untersuchung wird mehrere Schlüsselbereiche untersuchen, in denen KI in der Branche erhebliche Fortschritte macht.

What we can do for you