Was sind künstliche neuronale Netze und wie lernen sie? Wofür verwenden wir sie? Was sind einige Beispiele für künstliche neuronale Netze? Wie verwenden wir neuronale Netze?

In meinem Hauptberuf nutze ich neuronale Netzwerke, um beispielsweise Pläne für klinische Studien im PDF-Format in eine Risikoeinstufung für ein hohes oder niedriges Risiko umzuwandeln oder um Fragebögen zur psychischen Gesundheit wie GAD-7 mit entsprechenden Angaben in anderen Sprachen und Ländern abzugleichen .

Sie haben sicher schon Begriffe wie künstliche neuronale Netze gehört, sind sich aber vielleicht nicht sicher, was diese tun. Sind sie wirklich so toll, wie alle versprechen?

Neuronale Netzwerke sind eine Möglichkeit, ein Programm dazu zu bringen, sich selbst zu schreiben. Stellen wir uns vor, Sie möchten ein Programm schreiben, das erkennt, ob eine Person lächelt oder die Stirn runzelt.

In den Neunzigern oder frühen 2000ern hätte man dieses Problem gelöst, indem man eine lange, komplizierte Liste mit Regeln geschrieben hätte, um anhand der Pixel eines Bildes zu erkennen, ob es sich um ein Lächeln oder ein Stirnrunzeln handelte.

Heutzutage gibt es eine viel bessere Methode, aber dafür braucht man viel Wettbewerbsstärke. Man würde 1000 Bilder von lächelnden und 1000 Bilder von stirnrunzelnden Menschen sammeln und zu dem Schluss kommen, dass es eine Formel gibt, um aus den Werten in den Pixeln eine 1 für Lächeln und eine 0 für Stirnrunzeln zu erhalten… nur, dass wir die Formel nicht kennen!

Keine Sorge, wir können einfach viele verschiedene Formeln ausprobieren. Die Formel, die das Lächeln und Stirnrunzeln richtig hinbekommt, ist die richtige.

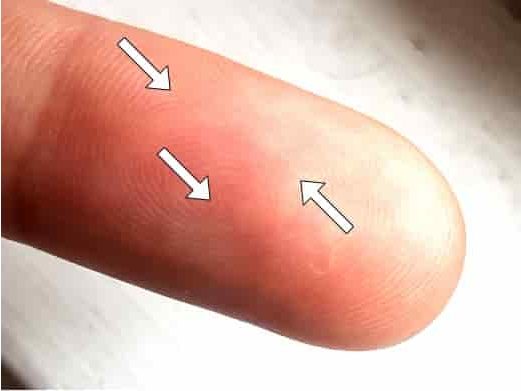

Die Idee, Anweisungen zu schreiben, die beschreiben, wie ein Bild zu interpretieren ist, scheint weit hergeholt. Aber einer der bekanntesten Algorithmen zur Fingerabdruckerkennung, der Bozorth-Algorithmus, besteht aus 1775 Codezeilen, die beschreiben, wie man Minutien (Merkmale wie Kreuzungen und Sackgassen) in einem Fingerabdruckbild findet. Sie können den Bozorth-Code auf Github bewundern.

Training neural networks

Zunächst beginnen wir mit einigen Annahmen. Wir lassen nicht einfach jede beliebige Formel zu. Normalerweise beinhaltet unsere Formel, dass wir die Pixelwerte im Bild nehmen und wiederholt summieren, sie mit einigen unbekannten Werten, den sogenannten Gewichten, multiplizieren, einige andere unbekannte Werte, die sogenannten Biase, hinzufügen und sie auf Null setzen, wenn sie negativ sind, bis wir eine einzelne Zahl erhalten. Ein neuronales Netzwerk für Bilder könnte dies etwa 20 Mal tun. Dies würde als Convolutional Neural Network (CNN) mit 20 Schichten bezeichnet werden.

Wenn Ihr Originalbild also in Graustufen und 100 x 100 Pixeln (10.000 Zahlen) vorliegt, kombiniert das neuronale Netzwerk diese über seine 20 Ebenen hinweg, um einen einzelnen Wert zwischen 0 und 1 zu erhalten.

Die unbekannten Bestandteile unseres neuronalen Netzwerks sind also die Gewichte und Verzerrungen, die zusammen als Parameter bezeichnet werden. Wie finden wir sie?

Nun, wir beginnen mit einer zufälligen Schätzung. Lassen Sie uns alle unsere Parameter auf Zufallszahlen setzen.

Dann können wir sehen, wie gut unser Modell zwischen Lächeln und Stirnrunzeln unterscheiden kann. Wahrscheinlich ist es nicht besser als ein Münzwurf, denn genau das haben wir getan: Wir haben eine Zufallsfunktion erstellt.

Aber hier liegt der Clou: Wir können einen mathematischen Trick namens Infinitesimalrechnung anwenden, also die Mathematik der Veränderung, um herauszufinden, wie stark jede Gewichtung oder Tendenz verändert werden muss, damit unser Modell besser zwischen Lächeln und Stirnrunzeln unterscheiden kann. Und an diesem Punkt wird praktisch jede Veränderung es verbessern, weil sie völlig nutzlos ist.

(Die Infinitesimalrechnung wurde von zwei der größten Wissenschaftler des 17. Jahrhunderts entdeckt, Isaac Newton und Gottfried Wilhelm Leibniz. Sie stritten sich darum, wer zuerst da war und wer wen plagiierte, doch keiner von ihnen hätte ahnen können, wie neuronale Netzwerke heute genutzt werden, um Memes in sozialen Medien zu empfehlen.)

Newton. Gemeinfreies Bild.

Leibniz. Gemeinfreies Bild.

Anschließend passen wir die Parameter ein wenig in die Richtung an, die die Leistung des Modells verbessert und es besser in die Lage versetzt, Lächeln und Stirnrunzeln auf unseren 1.000 Bildern zu erkennen.

Wir würden diese Anpassung tausende Male durchführen. Wenn wir alles richtig eingerichtet haben, würden wir erwarten, dass das Modell Grinsen und Grimassen nach und nach besser erkennt.

In der Praxis gibt das Modell nicht genau 1 oder 0 aus. Es gibt ungenaue Zahlen wie 0,86532 aus. Wir können eine Zahl namens Verlustfunktion berechnen, die angibt, wie weit diese Werte von den korrekten 0en und 1en entfernt sind. Mit der Zeit wird die Verlustfunktion kleiner.

Das oben beschriebene Beispiel ist für ein CNN. CNNs wurden für die Bildklassifizierung entwickelt. Neuronale Netzwerke können aber noch viele andere Dinge.

Ein derzeit heißes Thema sind Transformer , die sehr gut mit Sprachdaten umgehen können (Text, Sounddateien usw.). Sie funktionieren, indem sie eine Wortfolge durchgehen und die Aufmerksamkeit auf andere Wörter an anderer Stelle im Satz lenken, die für die aktuelle Arbeit relevant sind. Die beliebtesten Sprachen bei Google Translate verwenden mittlerweile Transformer-Netzwerke, und GPT-3 von OpenAI ist ein äußerst leistungsfähiges und hochentwickeltes Transformer-Netzwerk.

Sie können auch LSTMs oder Long Short Term Memory-Netzwerke haben, die sich gut an Informationen erinnern können, die früher in einem Dokument standen.

Transformers und LSTMs eignen sich auch gut zur Spracherkennung.

Ich habe hier darüber geschrieben, wie ähnlich neuronale Netzwerke dem menschlichen Gehirn sind.

Suchen Sie Experten in Natürlicher Sprachverarbeitung? Veröffentlichen Sie Ihre Stellenangebote bei uns und finden Sie heute Ihren idealen Kandidaten!

Veröffentlichen Sie einen Job

Generative KI Einführung Generative KI , ein Teilbereich der KI, verändert Branchen grundlegend und gestaltet die Zukunft. Durch die Nutzung fortschrittlicher Algorithmen kann generative KI Inhalte, Designs und Lösungen erstellen, die zuvor undenkbar waren. Durch die Verwendung von Modellen des maschinellen Lernens wie Generative Adversarial Networks (GANs) und Variational Autoencoders (VAEs) können generative KI-Systeme neue Daten erstellen, die die Muster und Strukturen der Trainingsdaten nachahmen.

Große Daten Das Aufkommen von Big Data hat ganze Branchen revolutioniert und traditionelle Geschäftsmodelle und Entscheidungsprozesse verändert. In dieser umfassenden Untersuchung gehen wir der Frage nach, was Big Data ist, welche erheblichen Auswirkungen es auf die Geschäftsstrategie hat und wie Unternehmen riesige Datenmengen nutzen können, um Innovationen voranzutreiben und sich einen Wettbewerbsvorteil zu verschaffen.

KI im Finanzwesen Die Integration künstlicher Intelligenz (KI) in den Finanzsektor hat die Arbeitsweise von Institutionen revolutioniert, von der Automatisierung von Abläufen bis hin zur Verbesserung der Kundenbindung und des Risikomanagements. Diese umfassende Untersuchung wird mehrere Schlüsselbereiche untersuchen, in denen KI in der Branche erhebliche Fortschritte macht.

What we can do for you