Tauchen Sie ein in die Welt der Natürlichen Sprachverarbeitung! Entdecken Sie modernste NLP-Rollen, die zu Ihren Fähigkeiten und Leidenschaften passen.

NLP-Jobs entdeckenWas sind künstliche neuronale Netze und wie lernen sie? Wofür verwenden wir sie? Was sind einige Beispiele für künstliche neuronale Netze? Wie nutzen wir neuronale Netze?

In meiner täglichen Arbeit verwende ich neuronale Netze, um beispielsweise klinische Studienpläne im PDF-Format in eine Hoch- oder Niedrigrisikobewertung umzuwandeln oder Fragebögen zur psychischen Gesundheit wie GAD-7 mit Äquivalenten in anderen Sprachen und Ländern abzugleichen .

Sie haben vielleicht schon einmal Begriffe wie „künstliche neuronale Netze“ gehört, sind sich aber möglicherweise nicht sicher, was sie bewirken. Sind sie wirklich alles, wofür sie gepriesen werden?

Neuronale Netze sind eine Möglichkeit, ein Programm dazu zu bringen, sich selbst zu schreiben. Stellen Sie sich vor, Sie möchten ein Programm schreiben, um festzustellen, ob eine Person lächelt oder die Stirn runzelt.

In den 1990er- oder frühen 2000er-Jahren gingen die Menschen an die Sache heran, indem sie eine lange, komplizierte Liste von Regeln aufstellten, um anhand der Pixel eines Bildes zu erkennen, ob es sich um ein Lächeln oder ein Stirnrunzeln handelte.

Heutzutage gibt es einen viel besseren Weg, aber man braucht viel Wettbewerbskraft. Sie würden 1000 Bilder von lächelnden Menschen und 1000 Bilder von stirnrunzelnden Menschen sammeln und entscheiden, dass es eine Formel gibt, um von den Werten in den Pixeln zu einer 1 für „Lächeln“ und einer 0 für „Stirnrunzeln“ zu gelangen … nur dass wir das nicht tun Kenne die Formel!

Keine Sorge, wir können einfach viele verschiedene Formeln ausprobieren. Derjenige, der das richtige Lächeln und Stirnrunzeln hervorruft, ist der Richtige.

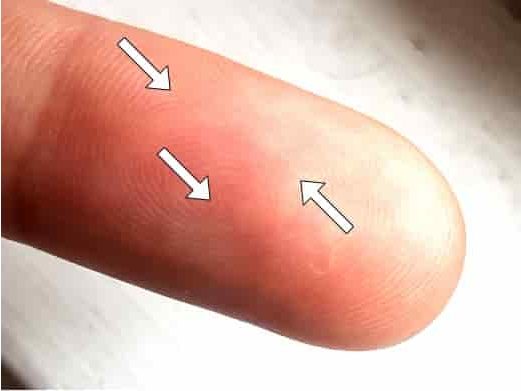

Die Idee, Anweisungen zu schreiben, um zu beschreiben, wie ein Bild zu interpretieren ist, scheint weit hergeholt. Aber einer der bekanntesten Algorithmen zur Fingerabdruckerkennung, der Bozorth-Algorithmus, besteht aus 1775 Codezeilen, die beschreiben, wie man Minutien (Merkmale wie Kreuzungen und Sackgassen) in einem Fingerabdruckbild findet. Den Bozorth-Code könnt ihr auf Github bestaunen.

Training neural networks

Zunächst beginnen wir mit einigen Annahmen. Wir erlauben nicht irgendeine Formel. Normalerweise besteht unsere Formel darin, die Pixelwerte im Bild zu nehmen und sie wiederholt zu summieren, sie mit einigen unbekannten Werten, sogenannten Gewichtungen, zu multiplizieren, einige andere unbekannte Werte, sogenannte Bias, hinzuzufügen und sie auf Null zu setzen, wenn sie negativ sind, bis wir eine einzelne Zahl erhalten . Ein neuronales Netzwerk für Bilder könnte dies etwa 20 Mal tun. Dies würde man als Convolutional Neural Network (CNN) mit 20 Schichten bezeichnen.

Wenn Ihr Originalbild also ein Graustufenbild mit 100 x 100 Pixeln (10.000 Zahlen) war, kombiniert das neuronale Netzwerk diese über seine 20 Schichten, um einen einzelnen Wert zwischen 0 und 1 zu erhalten.

Die unbekannten Bestandteile unseres neuronalen Netzwerks sind also die Gewichte und Bias, die zusammen als Parameter bezeichnet werden. Wie finden wir sie?

Nun, wir beginnen mit einer zufälligen Vermutung. Lassen Sie uns alle unsere Parameter auf Zufallszahlen setzen.

Dann können wir sehen, wie gut unser Modell zwischen Lächeln und Stirnrunzeln unterscheiden kann. Die Chancen stehen gut, dass es nicht besser funktioniert als ein Münzwurf, denn genau das haben wir getan: Wir haben eine Zufallsfunktion erstellt.

Aber hier liegt das Geniale: Wir können einen mathematischen Trick namens Infinitesimalrechnung anwenden, die Mathematik der Veränderung, um herauszufinden, um wie viel sich jedes Gewicht oder jede Tendenz ändern muss, damit unser Modell Lächeln besser von Stirnrunzeln unterscheiden kann. Und an diesem Punkt wird so ziemlich jede Änderung zu einer Verbesserung führen, weil sie völlig nutzlos ist.

(Infinitesimalrechnung wurde von zwei der großen Wissenschaftler des 17. Jahrhunderts, Isaac Newton und Gottfried Wilhelm Leibniz, entdeckt. Sie stritten sich darum, wer zuerst dort ankam und wer wen plagiierte, aber keiner konnte ahnen, wie neuronale Netze verwendet werden würden, um Memes in sozialen Netzwerken zu empfehlen Medien heute.)

Newton. Gemeinfreies Bild.

Leibniz. Gemeinfreies Bild.

Anschließend passen wir die Parameter ein wenig in die Richtung an, die die Leistung des Modells verbessert und es bei der Erkennung von Lächeln und Stirnrunzeln auf unseren 1000 Bildern verbessert.

Wir würden diese Anpassung tausende Male durchführen. Wenn wir alles richtig eingerichtet haben, erwarten wir, dass das Modell allmählich besser darin wird, Grinsen und Grimassen zu erkennen.

In der Praxis gibt das Modell nicht genau 1 oder 0 aus. Es werden unordentliche Zahlen wie 0,86532 ausgegeben. Wir können eine Zahl namens Verlustfunktion berechnen, die angibt, wie weit diese Werte von den korrekten Nullen und Einsen entfernt sind. Mit der Zeit wird die Verlustfunktion kleiner.

Das Beispiel, das ich oben beschrieben habe, bezieht sich auf ein CNN. CNNs wurden zur Bildklassifizierung entwickelt. Aber neuronale Netze können noch viele andere Dinge tun.

Ein aktuelles Thema sind Transformer , die sehr gut mit Sprachdaten (Text, Sounddateien usw.) umgehen können. Sie arbeiten, indem sie eine Wortfolge durchgehen und die Aufmerksamkeit auf andere Wörter an anderer Stelle im Satz richten, die für die aktuelle Arbeit relevant sind. Die beliebtesten Sprachen auf Google Translate verwenden mittlerweile Transformer-Netzwerke, und GPT-3 von OpenAI ist ein äußerst leistungsstarkes und hochentwickeltes Transformer-Netzwerk.

Sie können auch über LSTMs (Long Short Term Memory Networks) verfügen, die sich gut an Informationen von früher in einem Dokument erinnern können.

Transformer und LSTMs eignen sich auch gut für die Spracherkennung.

Ich habe hier darüber geschrieben, wie ähnlich neuronale Netze dem menschlichen Gehirn sind.

Tauchen Sie ein in die Welt der Natürlichen Sprachverarbeitung! Entdecken Sie modernste NLP-Rollen, die zu Ihren Fähigkeiten und Leidenschaften passen.

NLP-Jobs entdecken

Mittlerweile sind es Organisationen aller Größenordnungen und fast aller Sektoren werden zunehmend datengesteuert, insbesondere als größere Datenspeicher Systeme und schnellere Computer treiben die Leistungsgrenzen immer weiter voran.

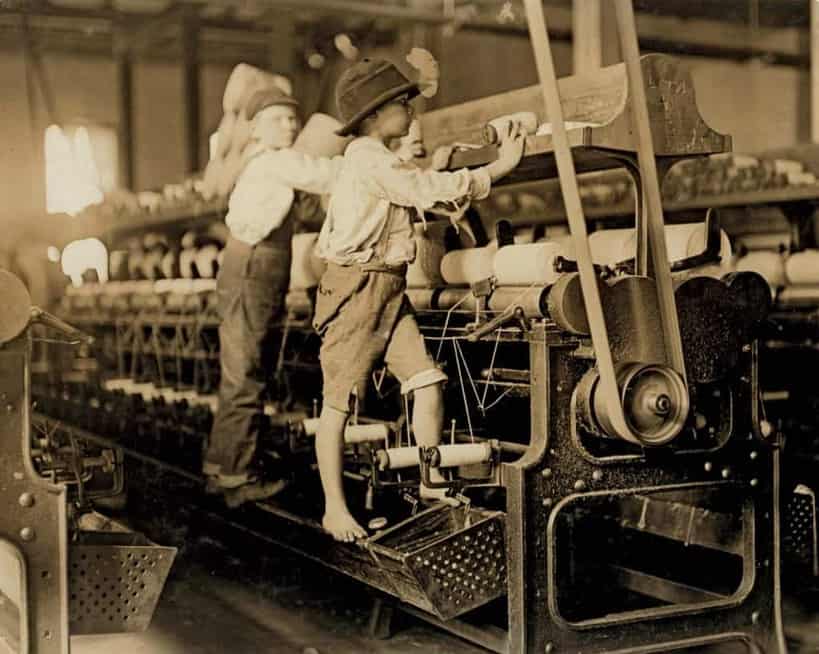

Aufgrund des umfangreichen Einsatzes von Technologie und der Arbeitsteilung hat die Arbeit des durchschnittlichen Gig-Economy-Arbeiters jeden individuellen Charakter und damit auch jeden Charme für den Arbeitnehmer verloren.

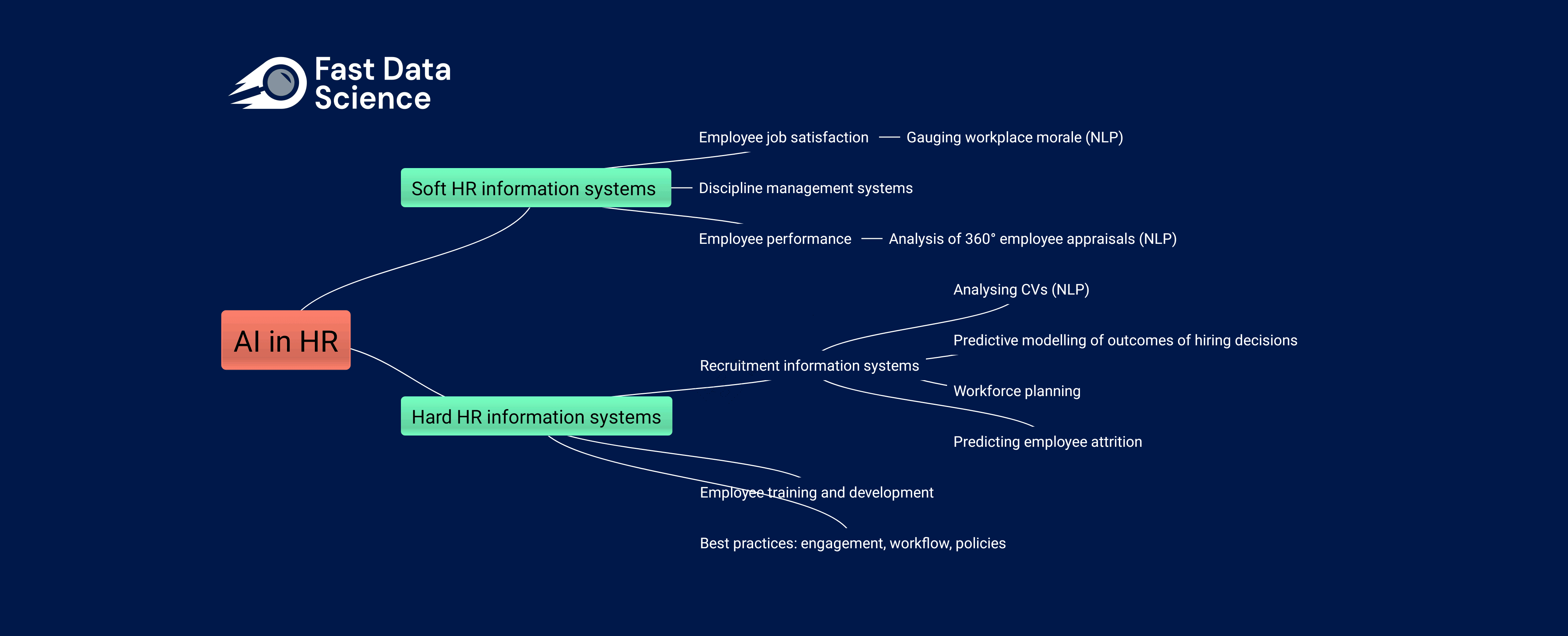

Die Auswirkungen von KI auf die Humanressourcen Die Arbeitswelt verändert sich rasant, sowohl aufgrund der Einführung traditioneller Data-Science-Praktiken in immer mehr Unternehmen als auch aufgrund der zunehmenden Beliebtheit generativer KI-Tools wie ChatGPT und Googles BARD bei nicht-technischen Arbeitnehmern.

What we can do for you